L’outil Google Search Console est indispensable pour la grande majorité des éditeurs de sites. Entièrement gratuit, il est particulièrement utilisé pour suivre les performances SEO de votre boutique en ligne.

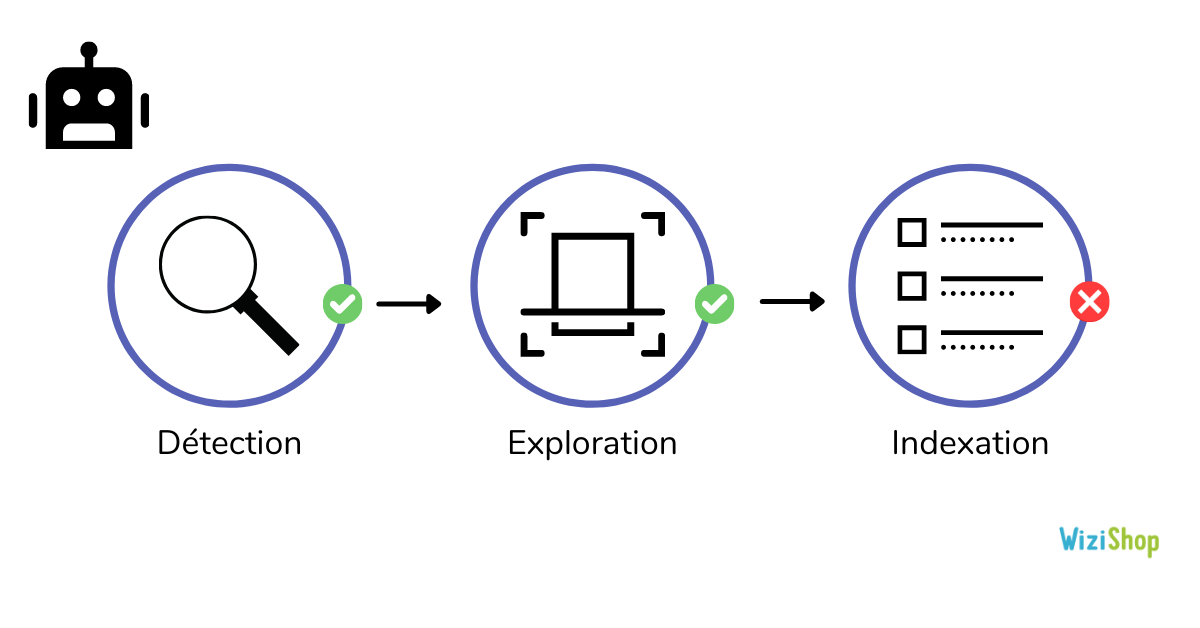

Un des onglets principaux de cet outil est celui dédié à l’index de votre site, et plus précisément à la couverture. Cette partie de la Search Console permet notamment d’avoir une vision précise du crawl effectué par Googlebot et de l’indexation de vos URLs.

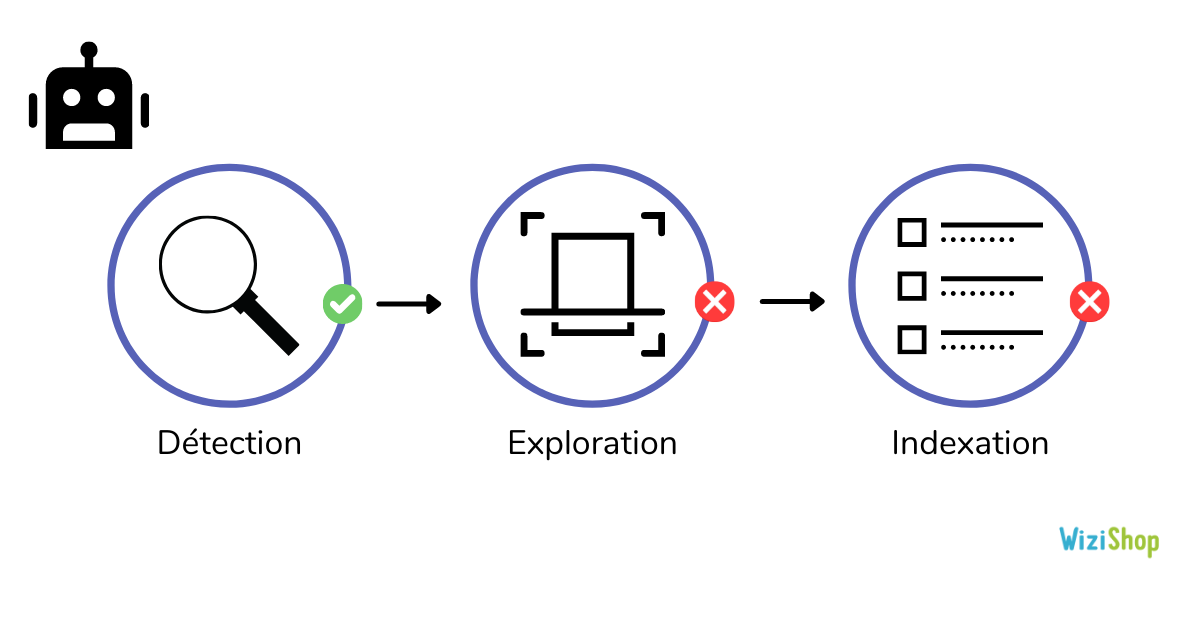

Vous allez pouvoir identifier les pages de votre site que Google a détectées, explorées et indexées ainsi que les éventuels problèmes rencontrés.

Malheureusement, pour une grande partie d’entre vous, ce rapport peut souvent être complexe à analyser. Entre les différentes erreurs et avertissements remontés ou encore l’exclusion de vos pages, il peut s’avérer difficile d’en ressortir des solutions concrètes.

C’est pour cette raison que dans cet article, je vais vous présenter en détail chaque élément de cet onglet.

Selon l’affichage de votre Search Console, rendez-vous directement au point dédié dans cet article pour le comprendre et l’analyser plus efficacement (les commandes CMD+F ou CTRL+F peuvent vous faire gagner du temps).

Cet article va également être alimenté et mis à jour selon les remontées de nos e-commerçants pour apporter le plus d’exemples et de cas pratiques possibles.

N’hésitez pas également à nous partager en commentaire vos retours d’expériences, nous vous citerons dans l’article pour mettre en avant vos solutions !

Le rapport de couverture d’index

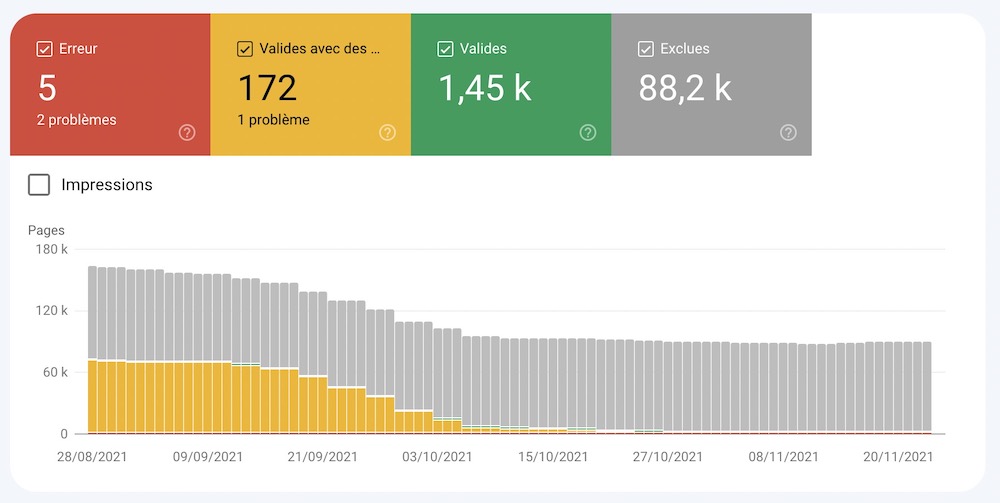

Tout d’abord, lorsque vous cliquez sur l’onglet “Couverture”, la première chose que vous allez voir apparaître est le récapitulatif de l’état d’indexation des différentes URLs de votre site dont Google a connaissance.

Sur ce récapitulatif, vous avez donc :

- Erreur : la page n’a pas pu être indexée. Elle n’apparaît pas dans les résultats de recherche

- Valides avec des avertissements : la page est indexée mais présente quelques problèmes à analyser

- Valides : la page est indexée. Elle peut ressortir dans les résultats de recherche

- Exclues : la page n’est pas indexée car Google a suivi la configuration de votre site et en a conclu qu’elle doit être exclue de l’index.

En tant qu’e-commerçant de WiziShop, il est fort possible que votre graphique ressemble à celui-ci, avec de nombreuses pages dans la section “exclues”.

Etant donné qu’un site marchand comporte de nombreuses URLs non indexables liées aux filtres à facettes, aux filtres de tri ou encore aux pages panier, c’est un comportement normal.

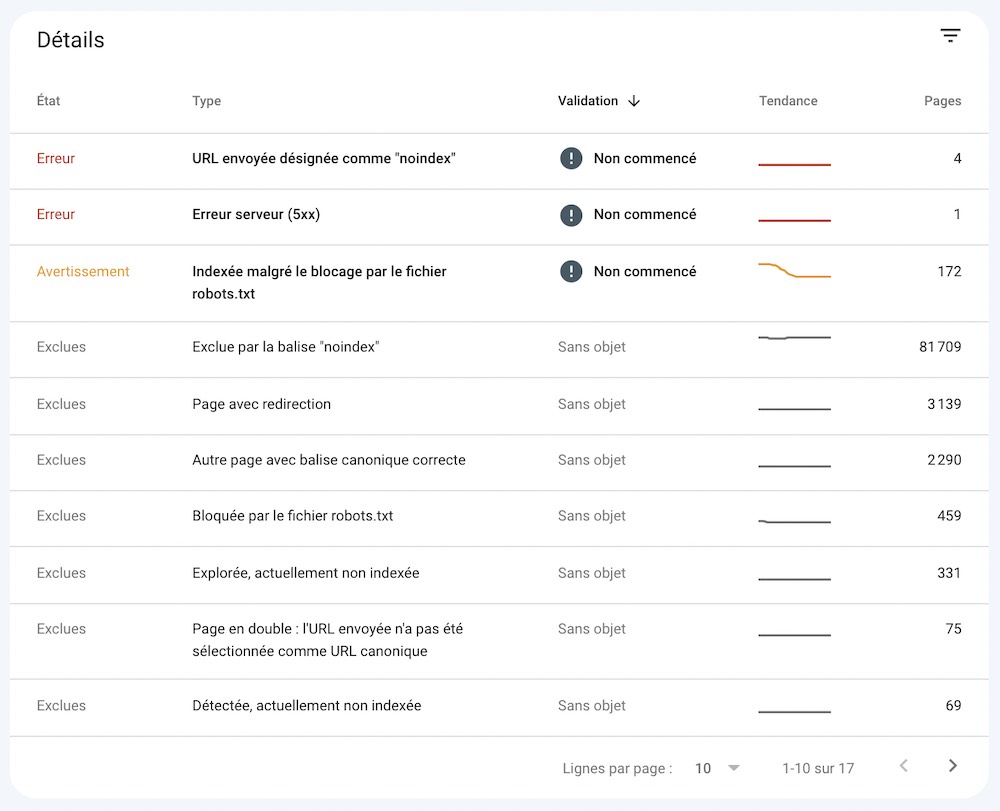

Ensuite, pour chacun des points cités précédemment, vous pouvez analyser les informations avec plus de précision lorsque vous descendez dans la page.

Je vous explique chacune des informations juste un peu plus bas dans l’article.

Le rapport “erreur” est le plus important. C’est celui-ci que vous devez analyser en premier pour corriger les éventuelles problématiques sur votre site qui empêchent l’indexation de vos pages.

Maintenant que vous comprenez mieux ce récapitulatif, il est maintenant temps de rentrer un peu plus dans les détails et de vous expliquer les différentes erreurs, avertissements et raisons d’exclusions qui peuvent s’afficher dans l’outil.

Les erreurs de la Search Console

Pour rappel, les pages qui sont affichées en erreur sont des pages qui n’ont pas pu être indexées par Google. Elles ne peuvent donc pas être référencées dans le moteur de recherche.

Il vous faut ensuite cliquer sur l’erreur pour identifier les URLs concernées.

Voici les différentes raisons qui peuvent occasionner ces erreurs et ces problèmes de non-indexation.

Erreur de serveur (5xx)

Lors de la visite du Googlebot, le serveur a renvoyé une erreur 500. Cette erreur a empêché Google d’explorer l’URL.

Ces erreurs sont la plupart du temps temporaires. Durant le crawl du robot, le serveur a pu être indisponible, surchargé ou mal configuré.

Solution :

Pour corriger l’erreur de serveur, il vous suffit de vérifier que l’URL est à nouveau accessible, puis de lancer une validation de la correction.

Si l’erreur persiste, pensez à contacter vos développeurs ou votre hébergeur.

Si vous êtes e-commerçant WiziShop, vous devez savoir que nous nous chargeons de tout cet aspect technique. Nos équipes réagissent très rapidement à ce type de problème.

Erreur de redirection

Lorsque Googlebot a visité votre URL, il a rencontré une de ces erreurs de redirection :

- Chaîne de redirection trop longue

- Boucle de redirection

- L’URL de redirection a dépassé la longueur maximale d’URL

- Chaîne de redirection avec une URL incorrecte

Ce type d’erreur est assez commun en e-commerce. Elle est souvent occasionnée par des suppressions de produits et de catégories.

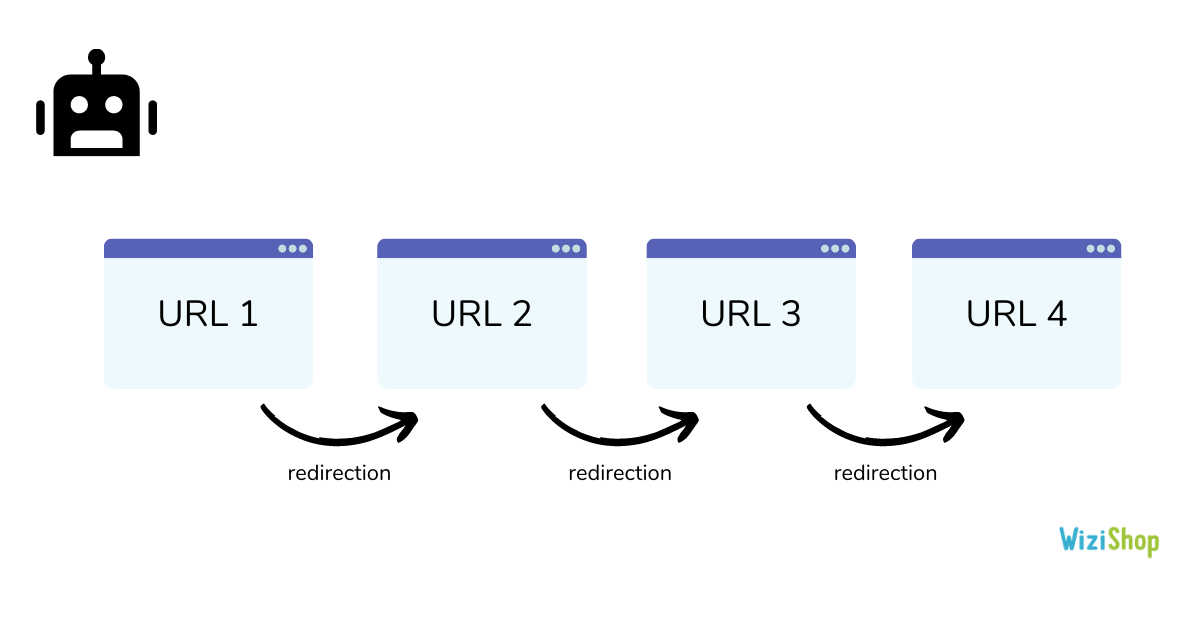

Par exemple, vous pouvez avoir créé des chaînes de redirections :

Ces mauvaises configurations peuvent apparaître lorsque vous supprimez un produit et que vous ajoutez une redirection vers un nouveau produit. Puis, quelques mois après, vous supprimez ce produit et vous ajoutez une redirection vers un nouveau. Et ainsi de suite. Les anciennes redirections vont rester et provoquer une chaîne.

La bonne pratique est de faire en sorte que :

- L’URL 1 renvoie vers l’URL 4

- L’URL 2 renvoie vers l’URL 4

- L’URL 3 renvoie vers l’URL 4

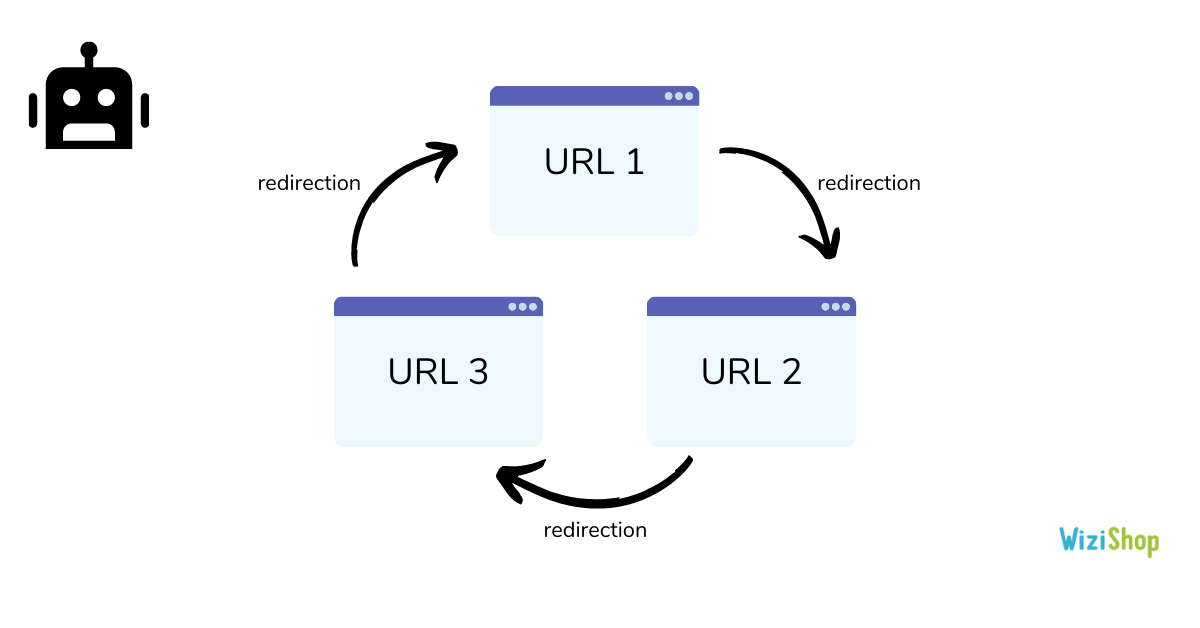

Un autre cas rencontré est celui des boucles de redirections :

La bonne pratique est d’avoir une page finale qui répond bien en code 200 et de renvoyer toutes les URLs directement vers celle-ci.

Toutes ces mauvaises configurations de redirections vont donc remonter comme erreurs dans votre rapport.

Solution :

Il faut analyser chacune de vos redirections pour les configurer correctement afin d’éviter les chaînes, boucles et autres erreurs. Chaque URL ne doit effectuer qu’une seule redirection.

En tant qu’utilisateur de la plateforme WiziShop, vous pouvez les analyser facilement en vous rendant dans “Configuration > Gestion des redirections”.

Ressource complémentaire : https://www.wizishop.fr/blog/redirection-301

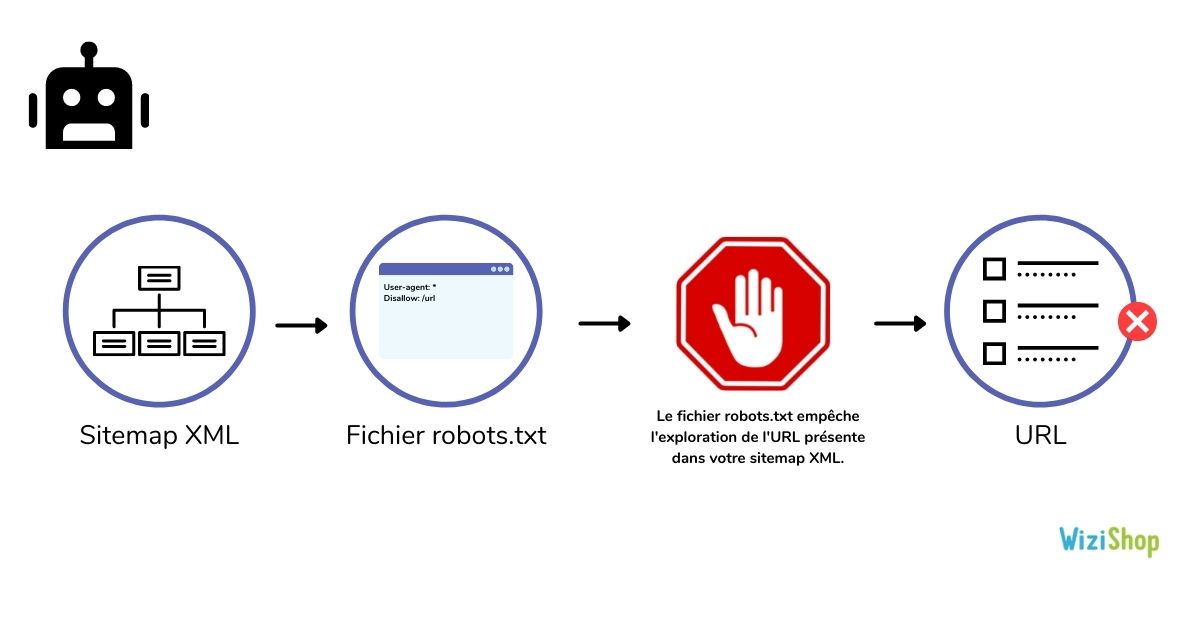

URL envoyée bloquée par le fichier robots.txt

Cette erreur signifie que vous avez envoyé une URL, via votre sitemap, mais qui est bloquée au niveau de votre fichier robots.txt. Selon les configurations que vous avez ajouté dans votre fichier robots.txt, cela peut empêcher l’exploration de certaines URLs ou répertoires de votre site.

Solution :

Si les URLs doivent être explorées, assurez-vous de supprimer la directive dans le fichier robots.txt. Dans le cas contraire, si l’URL ne doit pas être accessible, supprimez-là de votre fichier sitemap.

Vous pouvez d’ailleurs utiliser l’outil proposé par Google pour tester vos URLs : https://support.google.com/webmasters/answer/6062598?hl=fr.

En tant qu’utilisateur de la solution WiziShop, tout est techniquement optimisé à ce niveau : le fichier robots.txt est généré de manière automatique et contient uniquement des URLs à ne pas explorer. Par défaut, aucune URL de votre sitemap ne peut se retrouver bloquée par votre fichier robots.txt.

Ressources complémentaires : https://www.wizishop.fr/blog/fichier-robots-txt & https://www.wizishop.fr/blog/sitemap

URL envoyée désignée comme "noindex"

Cette erreur indique que vous envoyez des URLs via votre fichier sitemap mais que celles-ci contiennent la directive noindex. Cette balise noindex peut se trouver dans le code source ou dans l’en-tête HTTP.

Solution :

Là encore, si les URLs concernées doivent être indexées, supprimez le noindex. En revanche, si elles ne doivent pas être indexées, supprimez-les du fichier sitemap.

Sur WiziShop, automatiquement, chaque page que vous indiquez en noindex ne sera pas incluse dans le fichier sitemap afin de vous éviter cette erreur.

Ressource complémentaire : https://www.wizishop.fr/blog/balise-noindex

L'URL envoyée semble être une erreur de type "soft 404"

Le soft 404 est représenté par une URL qui répond en code 200 mais qui qui affiche une page 404 ou qui à l’apparence d’une 404 (aucun contenu).

Par exemple, en e-commerce, une catégorie sans produit peut remonter dans cette section.

Lorsque Googlebot va se rendre sur l’URL, il va tomber sur une page accessible, sans contenu ni produit, qui a sensiblement l’aspect d’une page 404 :

Cette erreur va donc apparaître ici si vous possédez dans votre fichier sitemap des URLs de ce type.

Solution :

Pour corriger ce problème, dans le cas où l'URL doit bien afficher une 404, il faut bien configurer le code HTTP. Supprimez-là ensuite de votre fichier sitemap.

Si cette URL doit être indexée, optimisez-là afin d’éviter qu’elle ait l'aspect d’une page 404 en ajoutant du contenu unique et pertinent.

L'URL envoyée renvoie une demande non autorisée (401)

Votre fichier sitemap contient des URLs avec un code de réponse 401. Ce code HTTP signifie que l’accès est non autorisé.

Le code HTTP 401 concerne généralement les environnements de test et de pré-production d’un site qui nécessitent des identifiants et mots de passe pour se connecter.

Solution :

Dans le cas où la page doit être bloquée et accessible via une authentification, assurez-vous de la supprimer de votre fichier sitemap. Sinon, vous devez autoriser Google à y accéder en supprimant l'authentification.

URL envoyée introuvable (404)

Votre fichier sitemap contient des URLs qui n’existent pas sur votre site (404).

Solution :

Si votre page n’existe pas, pensez à la supprimer de votre fichier sitemap. Vérifiez également qu’aucun lien ne pointe vers cette page.

Il est également possible que cette page ait été supprimée par erreur. Si c’est le cas, restaurez le contenu de la page et validez la correction.

L'URL envoyée a renvoyé l'erreur 403

Ce cas est assez similaire à celui de l’erreur 401. La différence est que le code HTTP 403 signifie que le serveur interdit l’accès à cette URL. Aucune authentification n’est possible.

Solution :

Comme pour le code 401, si ces URLs doivent refuser l’accès aux internautes, retirez-les du fichier sitemap. Sinon, faites en sorte d’afficher un code HTTP adapté.

URL bloquée en raison d'un autre problème de type 4xx

Votre fichier sitemap contient des URLs qui renvoient des codes de réponse différents de la 401, 403 et 404.

Solution :

Vérifiez les différentes URLs ainsi que les codes d’erreurs associés. Analysez les problèmes et corrigez-les.

Comme pour les précédentes, si les URLs en erreur ne doivent pas être détectées, supprimez-les de votre fichier sitemap.

Pour l’ensemble de ces erreurs, une fois que le problème est corrigé, le bouton “valider la correction” vous permet d’informer Google de vos modifications.

Il vous enverra ensuite un e-mail pour vous informer si le problème est corrigé ou si celui-ci persiste.

Les avertissements de la Search Console

À côté des erreurs, vous allez ensuite retrouver la section “Valides avec des avertissements”.

Seulement deux types d’avertissements peuvent remonter dans cet onglet.

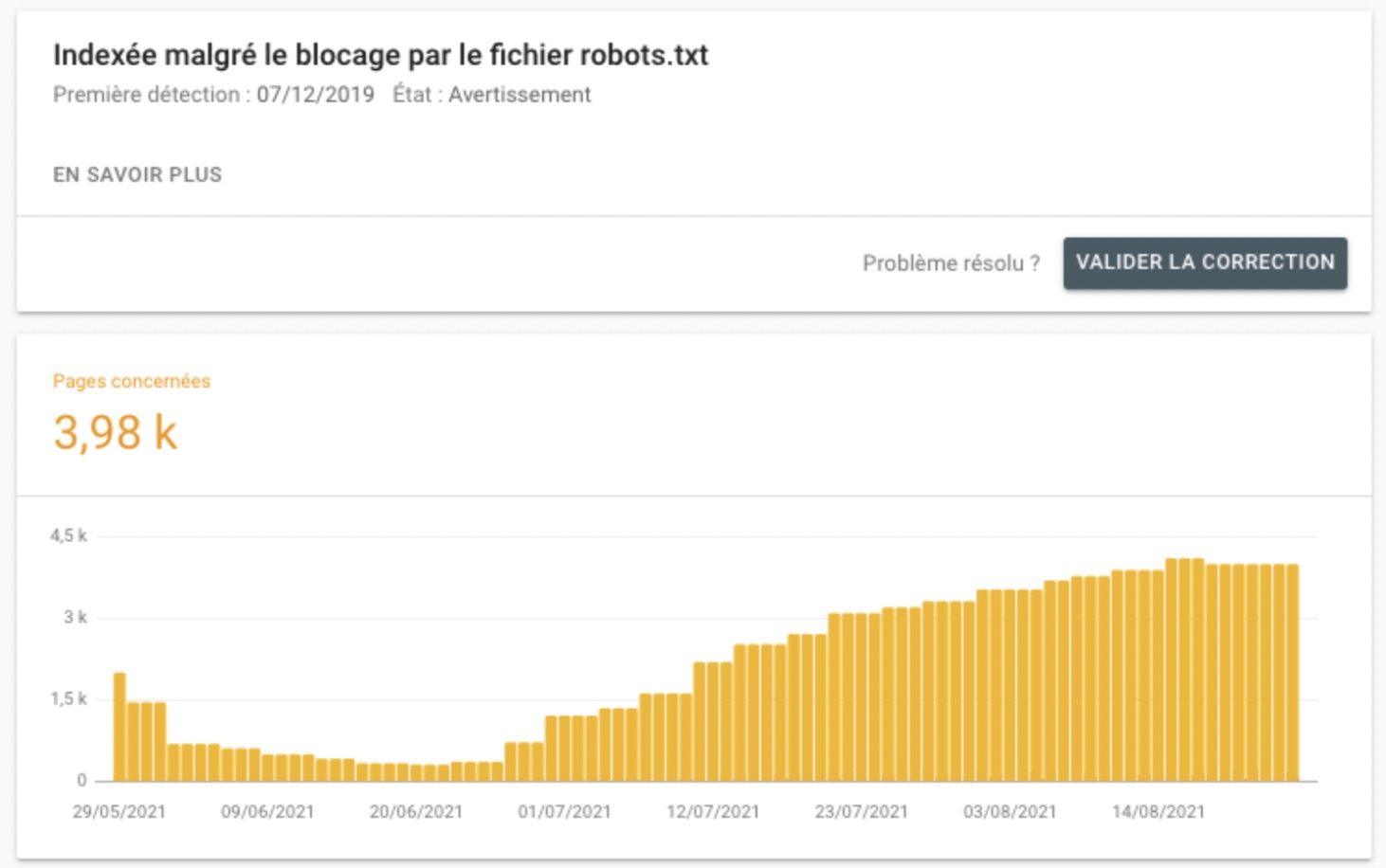

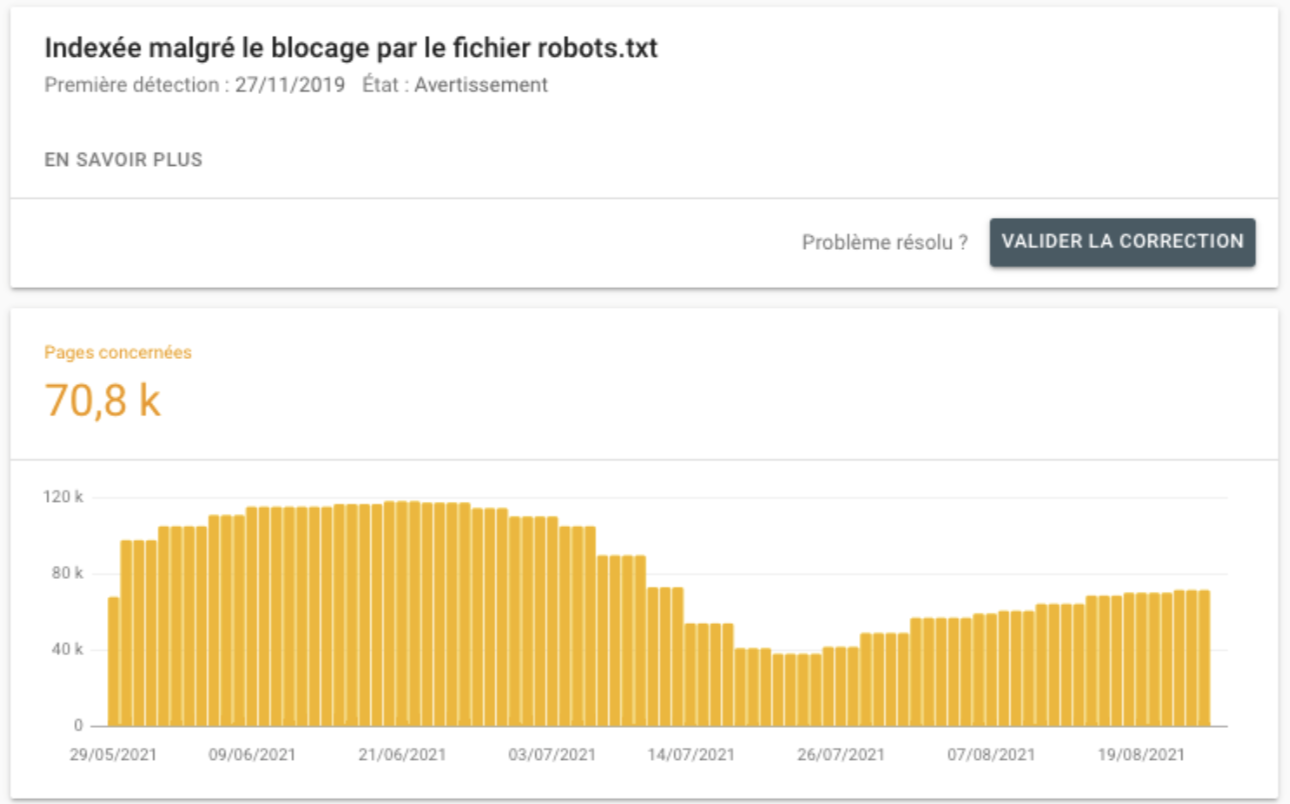

Indexée malgré le blocage par le fichier robots.txt

Cet avertissement signifie que Google a décidé d’indexer des URLs qui sont pourtant bloquées dans le fichier robots.txt.

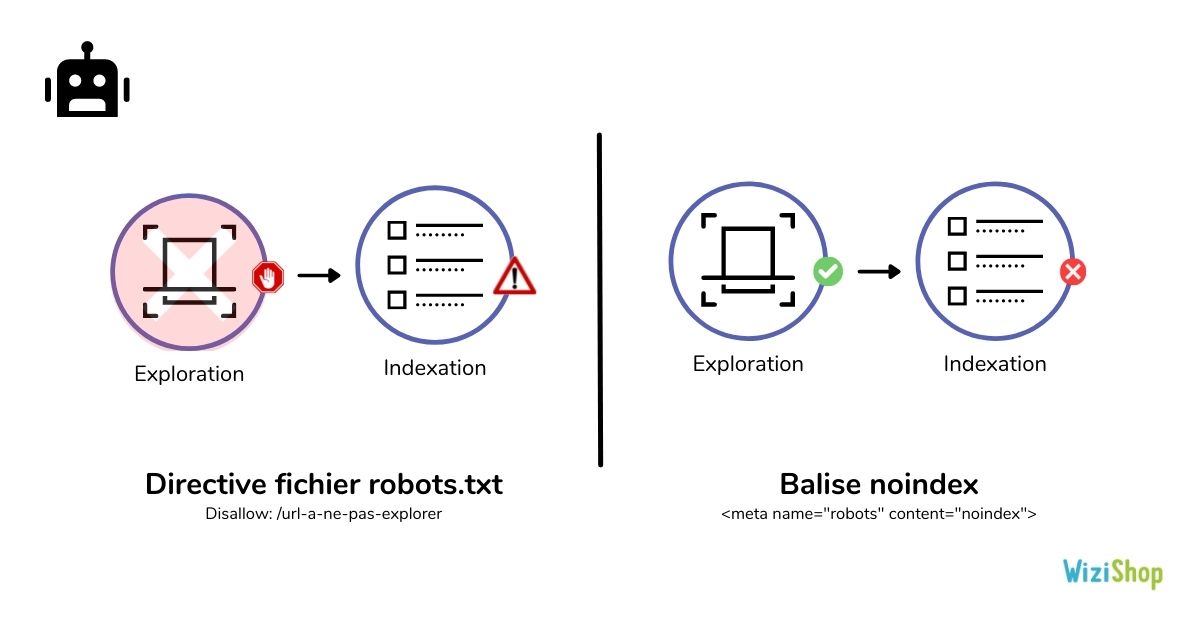

Pour rappel, le fichier robots.txt permet d'empêcher l’exploration des URLs, mais pas l’indexation.

Ce qui signifie que si Google identifie des liens pointant vers ces URLs bloquées, il peut prendre la décision de les indexer, sans même les explorer.

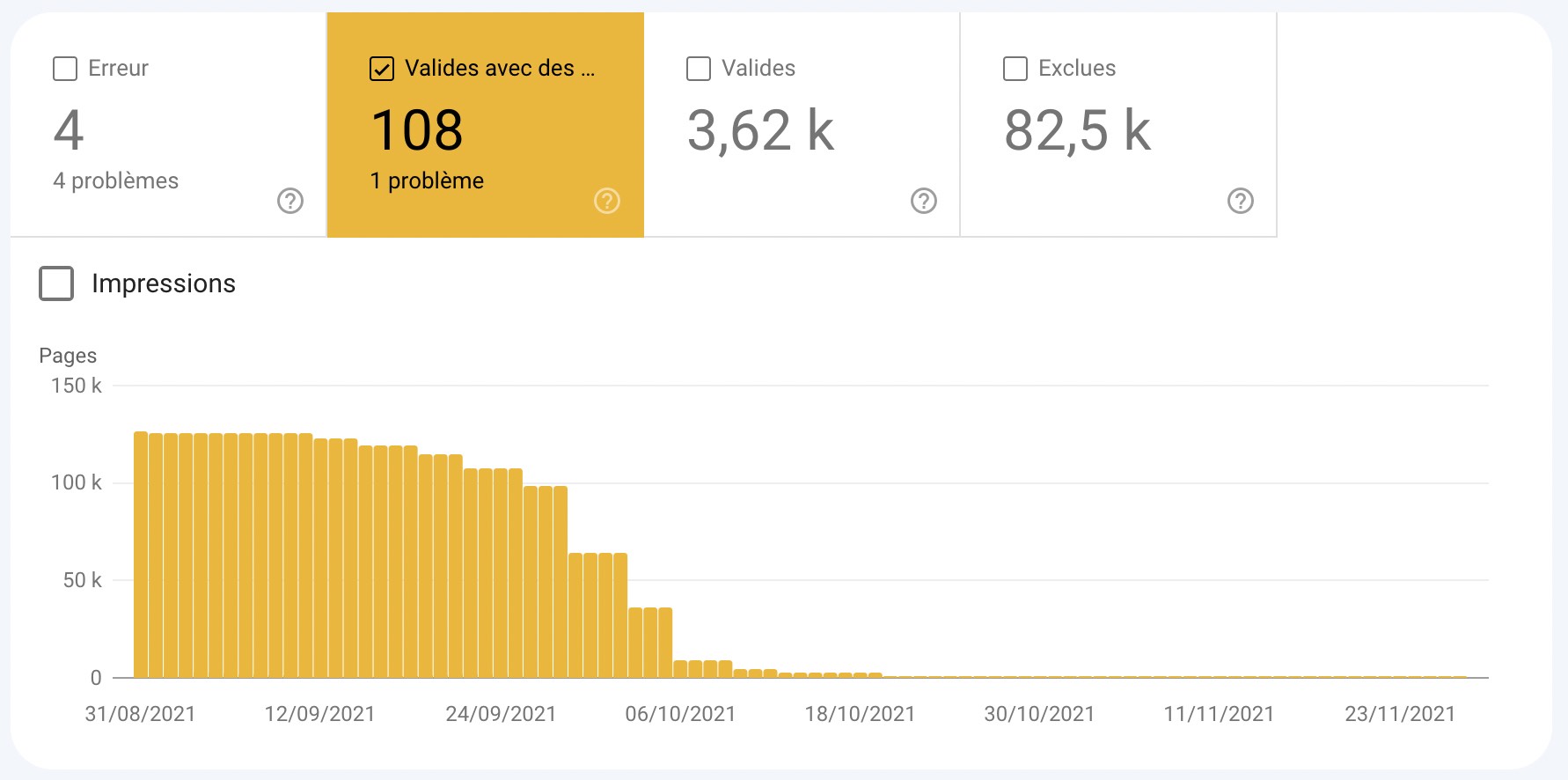

C’est une problématique qui a d’ailleurs été remontée par un bon nombre de nos e-commerçants :

Exemple n°1 : 3 980 URLs indexées malgré le blocage par le fichier robots.txt

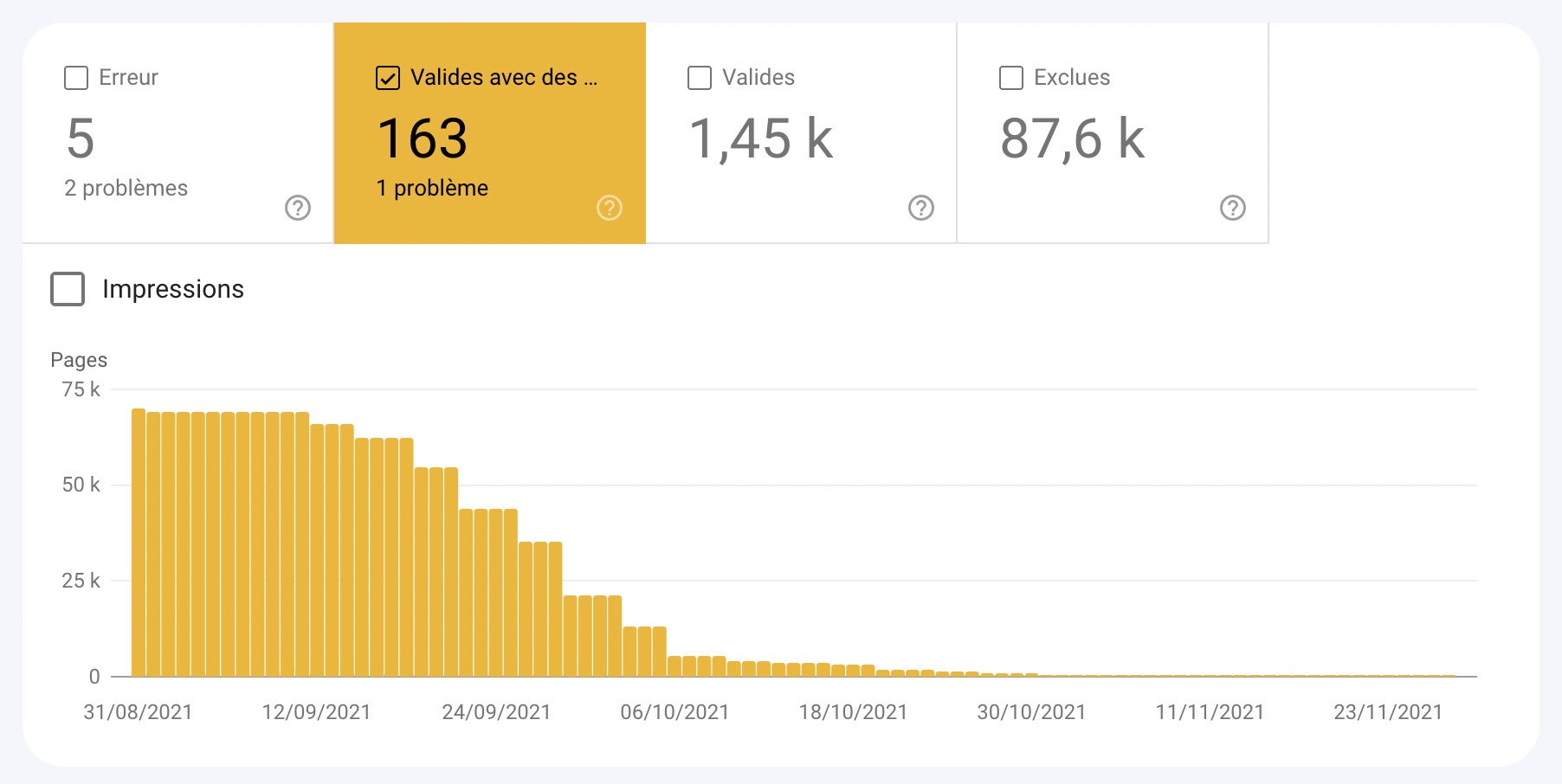

Exemple n°2 : 70 800 URLs indexées malgré le blocage par le fichier robots.txt

Sur WiziShop, les URLs générées par les filtres possèdent, par défaut, une balise noindex. Pour renforcer ce blocage et optimiser le budget crawl, nous avions également décidé de bloquer l’exploration dans le fichier robots.txt.

Le problème étant que Google a détecté les différents liens vers les filtres dans le maillage interne et a décidé de les indexer. Étant donné qu’il ne les explore pas réellement, il ne détecte pas la balise noindex.

Solution :

Si elles doivent être explorées, retirez la directive de votre fichier robots.txt.

Dans le cas où elles ne doivent pas l’être, je vous rappelle que le blocage par robots.txt empêche Google d’explorer vos pages et donc de détecter la balise noindex. Ces avertissements ne peuvent pas se corriger tout seul. Si vous souhaitez désindexer les URLs indexées, voici la méthode :

1. Ajouter ou vérifier qu’une balise noindex est bien présente sur toutes les pages qui ne doivent pas être indexées

2. Retirer les directives du fichier robots.txt pour que Google puisse explorer vos URLs et comprendre que ces pages possèdent une balise noindex (Google explique dans sa documentation que le robots.txt n’est pas le bon procédé. Il est plutôt recommandé d’utiliser la balise noindex)

3. Attendez que le rapport “Indexée malgré le blocage par le fichier robots.txt” retombe à 0

4.a. Si vous avez un site de petite ou moyenne taille, avec quelques milliers d’URLs non indexables, vous pouvez conserver cette configuration

4.b. Si vous avez un site avec plusieurs centaines de milliers d’URL, la question du budget crawl entre en compte. Lorsque vous rendez accessible un très grand nombre d’URLs il est important d’optimiser l’efficacité de l’exploration. Dans ce cas là, il est préconisé de rendre les différents liens internes pointants vers ces pages inaccessibles pour Google via l’utilisation du Javascript / Ajax ou encore des techniques d’obfuscation.

Quand vous le pouvez et que le type d’URL le permet, je vous conseille également d’opter pour des blocages via des authentifications si ces URLs concernent des répertoires non autorisés.

Solution sur WiziShop :

Pour corriger ce problème sur WiziShop, nous avons donc retiré les directives associées aux filtres dans le fichier robots.txt. Nous avons ensuite transformé les balises standards <a href> en <button onclick> afin que Google ne puisse plus détecter les liens internes vers ces pages.

Bien entendu, la balise noindex reste présente sur chaque page générée pour éviter l’indexation au cas où le moteur de recherche les détecte et les explore.

Cette correction a réduit drastiquement les avertissements dans la search console de nos e-commerçants :

Exemple n°1 : De 130 000 pages indexées malgré le blocage par le fichier robots.txt à 108

Exemple n°2 : De 70 000 pages indexées malgré le blocage par le fichier robots.txt à 163

Toutes ces pages se sont déplacées dans le rapport des pages exclues, au niveau de “Exclue par la balise noindex”.

Nos analyses ont démontré que suite à cette suppression des paramètres dans le fichier robots.txt, aucune boutique n’a subi de perte SEO.

Si vous possédez un site avec plusieurs dizaines de milliers d’URLs, je vous invite à vérifier le parcours de googlebot sur votre site avec notre partenaire Seolyzer.

Cet outil d’analyse de logs vous permet de suivre directement les URLs visitées par googlebot et d’identifier le temps passé sur les différentes sections de votre site. Vous pouvez donc avoir une vue précise de vos filtres et savoir si oui ou non ils posent problème.

Ressource complémentaire : https://www.wizishop.fr/blog/seolyzer

En fonction de vos analyses, je vous rappelle que via du développement spécifique, vous pouvez obfusquer les liens internes vers les filtres à facette sur votre boutique WiziShop. La personnalisation HTML ou encore l’accès FTP vous donnent la possibilité d’effectuer ces modifications.

Indexée sans contenu

Cet avertissement signifie que Google a indexé certaines URLs de votre site, mais pour diverses raisons, il n’arrive pas à en lire le contenu : cloaking, format non supporté, etc.

Solution :

Récupérez les URLs et utilisez l’outil d’inspection d’URL de la search console pour analyser ce que voit Google et appliquer les corrections.

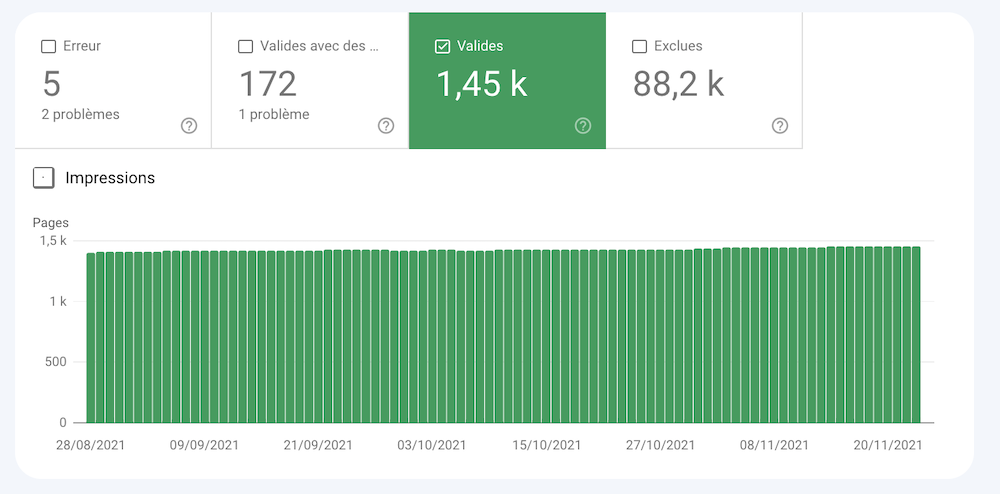

Valides

Le rapport des URLs valides contient toutes les pages indexées par le moteur de recherche. Il existe deux types de pages valides.

Envoyée et indexée

Les URLs affichées ici sont toutes celles que vous avez envoyées via un fichier sitemap et qui sont indexées.

Solution :

Aucune action à effectuer

Dans le cadre d’un site e-commerce qui ajoute fréquemment des produits et rédige des articles de blog, le rapport de pages indexées valides devrait augmenter progressivement avec le temps.

Indexée, mais non envoyée via un sitemap

Le moteur de recherche a indexé des URLs de votre site qui ne sont pas présentes dans votre fichier sitemap.

Solution :

Dans le cas où ces URLs doivent être indexées, pensez à les rajouter dans votre fichier sitemap.

En revanche, si elles ne doivent pas être indexées, ajoutez une directive noindex ou appliquez d'autres méthodes de blocage adaptées à votre site.

Exclues

Pour finir, le dernier onglet que vous allez retrouver dans votre couverture est celui des pages exclues. Ce sont les pages qui ne sont pas indexées sur votre site.

Les informations et données affichées ici sont très intéressantes pour analyser d'éventuels problèmes techniques sur votre site web ou encore des soucis d’indexation.

Exclue par la balise "noindex"

Ces URLs sont exclues de l’indexation car elles contiennent une directive noindex (dans le HTML ou dans l’en-tête HTTP).

Solution :

Si les URLs listées ici ne doivent pas être indexées, vous n’avez aucune action à effectuer. Le seul conseil que je peux vous donner est de réduire au maximum les liens internes vers ces pages pour éviter d’envoyer trop de jus SEO vers ces pages en noindex.

Comme vu précédemment, en tant qu’e-commerçant WiziShop, vous allez par exemple retrouver dans cette section les pages de filtres ou encore les pages du moteur de recherche interne. Vous n’avez donc aucune correction à effectuer de votre côté.

Dans le cas où ces pages doivent être indexées, il faut que vous retiriez la balise noindex.

Bloquée par l'outil de suppression de pages

La Search Console vous propose un outil de suppression des URLs de son index. Si vous l’avez utilisé pour supprimer des URLs, celles-ci ne seront pas indexables pendant une durée de 90 jours.

Passé ce délai, Google pourra indexer à nouveau ces URLs.

Solution :

L’outil de suppression des URLs n’est pas une solution viable sur le long terme pour empêcher l’indexation de certaines pages sur votre site. Il est préconisé d’utiliser plutôt la balise noindex.

Bloquée par le fichier robots.txt

Le fichier robots.txt permet d'empêcher l’exploration de certaines URLs.

Solution :

Si les URLs bloquées dans votre fichier robots.txt ne sont pas importantes, aucune action n’est requise. Attention, comme vous l’avez vu précédemment, cela ne signifie pas que la page ne sera pas indexée.

Dans le cas où certaines URLs bloquées doivent être explorées, il faudra retirer la directive présente dans le fichier robots.txt.

Bloquée en raison d'une demande non autorisée (401)

Comme vu précédemment, le code 401 signifie que Google n’a pas reçu l'autorisation d’accéder à ces URLs.

Solution :

Vérifiez tout d’abord que ces URLs doivent bien être inaccessibles pour Google.

En analysant ces URLs, si vous détectez des répertoires sensibles, essayez de trouver comment Google est tombé dessus. Il est possible que des liens internes ou externes pointent vers ces URLs.

Explorée, actuellement non indexée

Suite aux problèmes d’indexation de plus en plus fréquents rencontrés sur Internet, il est fort possible que des URLs de votre site remontent dans cette section.

“Explorée, actuellement non indexée” signifie que Google a bien crawlé votre URL mais n’a toujours pas été indexée.

Plusieurs raisons peuvent en être la cause :

- Google vient tout simplement de découvrir la page et il va bientôt l’indexer

- Google a déterminé que cette URL n’était pas assez pertinente pour être indexée : contenu faible ou de mauvaise qualité, contenu dupliqué, profondeur de la page, etc.

Solution :

Dans le cas où votre URL vient d’être publiée récemment, patientez avant d’en tirer des conclusions.

Si cela fait plusieurs semaines que votre URL est dans ce rapport, il va falloir analyser votre page pour trouver des pistes d’amélioration (analyse de l’intention de recherche, amélioration du contenu, ajouts de liens internes, etc).

Détectée, actuellement non indexée

Les URLs qui remontent ici sont celles que Google a détectées mais pas encore explorées. Elles se sont ajoutées à la file d’attente et vont être explorées prochainement.

Cela est souvent dû au fait que Google a reporté l’exploration pour cause de surcharge du site web ou tout simplement parce qu'il n’a pas encore eu le temps de les explorer.

Attention, une autre raison peut-être liée au fait que Google estime que la qualité globale de votre site est faible. Il va donc prendre beaucoup plus de temps à explorer les nouvelles pages.

Solution :

Dans la plupart des cas, il suffit d’attendre que Google explore les différentes URLs. Si vous venez de lancer votre site, vous allez rencontrer de nombreuses URLs dans ce rapport, il faut donc faire preuve de patience.

Si vous vous apercevez que de nombreuses URLs s’ajoutent à ce rapport et qu’elles ne sont jamais explorées après un certain temps, il est possible que les robots rencontrent quelques problèmes lors du crawl de votre site. Vous pouvez utiliser l’analyse de logs et vérifier, par exemple, que votre site ne contient pas de pièges à robots (filtres, plugins mal configurés, etc).

Cela peut également être occasionné par la faible qualité de votre contenu. Dans ce cas, il faut retravailler et améliorer vos pages.

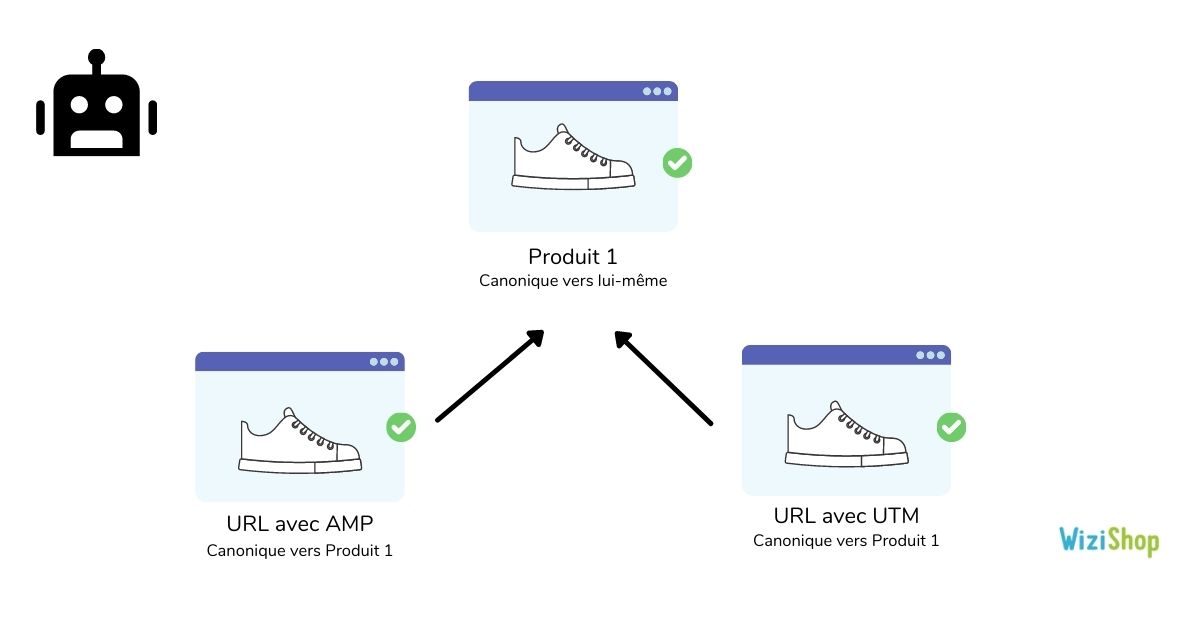

Autre page avec balise canonique correcte

Google liste ici les URLs qui possèdent une URL canonique vers une autre page, correctement sélectionnée par Google comme page principale.

Solution :

Si ces URLs sont bien des pages dupliquées à ne pas indexer, vous n’avez aucune action à effectuer.

En revanche, si les URLs analysées ne sont pas des pages dupliquées et qu’elles doivent être indexées, il convient de modifier la balise canonical pour la faire pointer vers elle-même.

En tant qu’e-commerçant WiziShop, les URLs qui vont ressortir ici sont celles liées à l’AMP (si vous l’avez activé). Vous pouvez également avoir des URLs d’affiliation ou des UTM.

Ressource complémentaire : https://www.wizishop.fr/blog/url-canonique

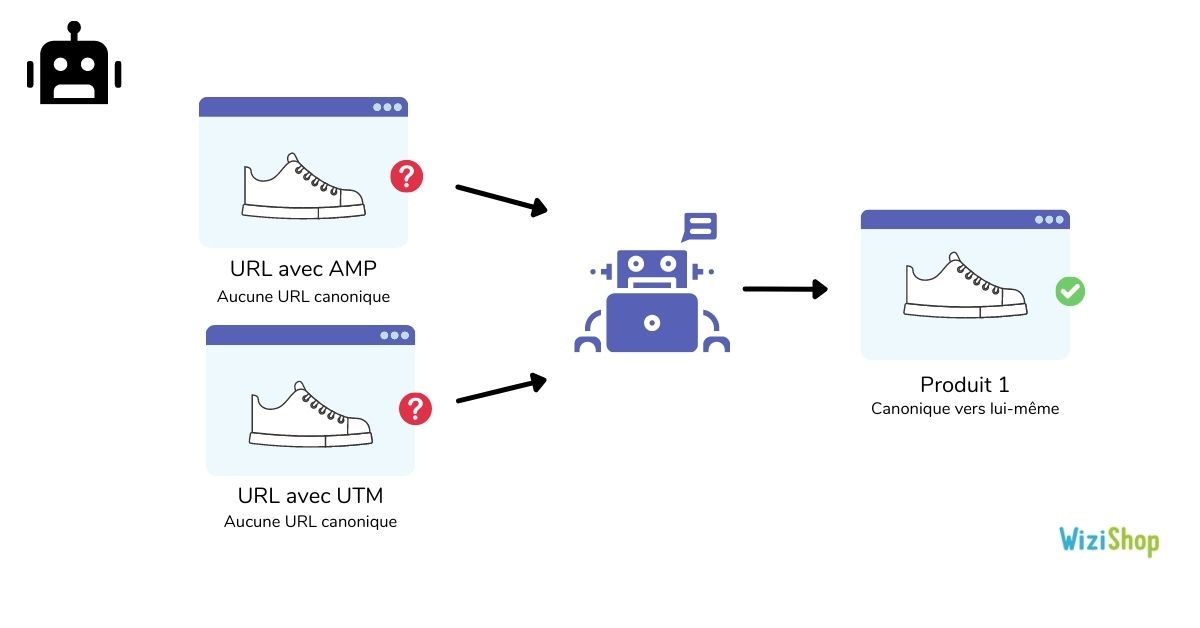

Page en double sans URL canonique sélectionnée par l'utilisateur

Google a identifié ces URLs comme des doublons. Aucune URL canonique n’est spécifiée. Le moteur de recherche les a donc exclues.

En ajoutant l’URL dans l’inspecteur d’URL, vous pouvez analyser l’URL sélectionnée par Google comme canonique.

Solution :

Vous devez ajouter des URLs canoniques sur chacune de vos pages pour afficher des directives claires vis-à-vis de Google. Dans ce cas là, indiquez l’URL canonique vers la page principale.

Si vous ne souhaitez pas que ces URLs se référencent et s’indexent, optez plutôt pour l’ajout d’une balise noindex. Dans le cas où elles ne doivent pas du tout exister, vous pouvez également les supprimer (tout en vérifiant qu’aucun lien ne pointent vers elles).

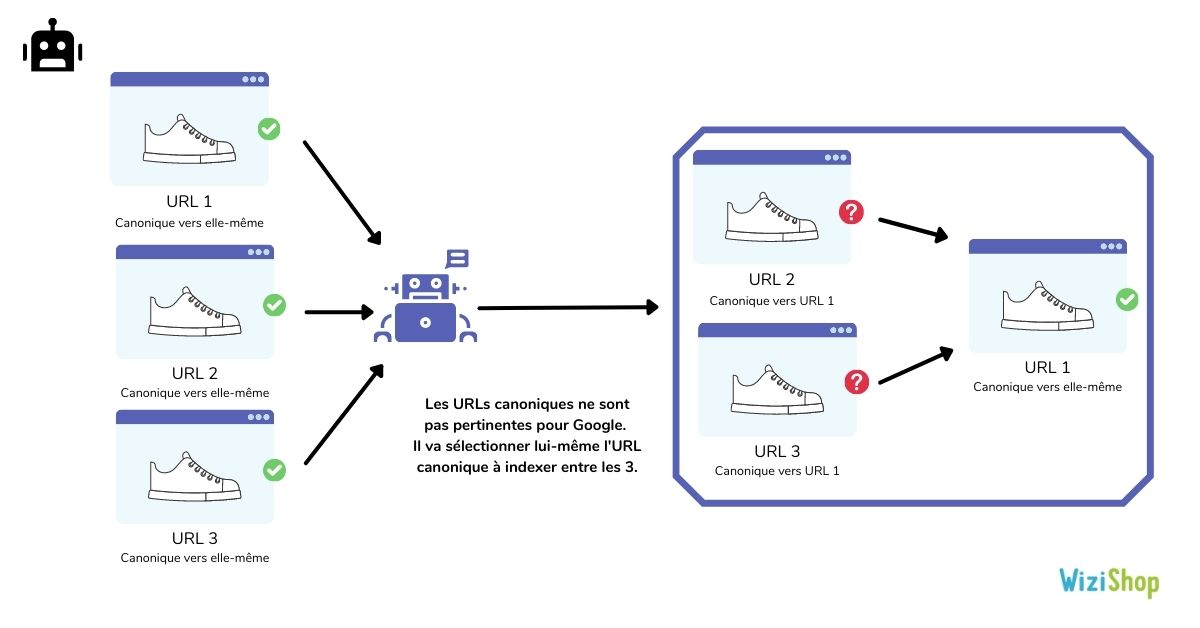

Page en double, Google n'a pas choisi la même URL canonique que l'utilisateur

Dans cette section, Google va vous afficher les URLs qui contiennent une URL canonique mais qui sont, pour lui, non pertinentes à être canoniques. Il sélectionne donc une autre URL canonique à indexer.

Ce cas de figure arrive souvent lorsque votre site web contient des pages avec peu de contenu et qui sont assez similaires à d’autres URLs.

Solution :

Là encore, vous pouvez utiliser l’outil d’inspection d’URL pour savoir quelle est l’URL que Google a jugé plus pertinente à indexer et rendre canonique. Si cela a du sens, définissez l’URL canonique vers celle préconisée par Google.

Dans le cas contraire, il faudra retravailler votre page pour la rendre plus unique.

Introuvable (404)

Les URLs listées ici ont retourné une erreur 404 lors du crawl de Googlebot. Ces URLs ne sont pas présentes dans le sitemaps mais le moteur de recherche les a détectées.

Il est possible que ce soit des pages qui ont existé dans le passé ou des URLs qui possèdent des liens depuis d’autres sites.

Solution :

Dans le cas où ces URLs doivent bien affichées un code 404 et qu’elles ont été supprimées récemment, Google continuera à essayer d’y accéder pendant un certain temps puis oubliera l’URL. Si la 404 est intentionnelle, ce n’est pas un problème.

En revanche, il convient de vérifier que plus aucun lien ne pointe vers cette URL. Si des liens externes pointent vers celle-ci, il peut-être intéressant de mettre en place une redirection 301 vers une autre URL similaire et pertinente.

Si ce sont des URLs importantes qui ne doivent pas être supprimées, il est important de corriger cette erreur et de restaurer votre contenu.

Pensez également à vérifier la date d’exploration de l’URL. Il est possible que celle-ci ne soit plus explorée depuis plusieurs mois.

Page avec redirection

Les URLs sont des redirections, elles sont donc exclues de l’index.

Solution :

Dans la majorité des cas, vous n’avez rien à corriger ici, si ce n’est vérifier que les URLs avec des redirections sont correctes.

Soft 404

Comme vu précédemment, le soft 404 correspond aux URLs qui n’affichent pas un code 404 mais ressemble fortement à une page 404.

Solution :

Pour les URLs qui sont bien des 404, vous devez configurer un code de réponse 404.

Si elles ne sont pas censées être des 404, il va falloir retravailler le contenu de la page pour la rendre pertinente et qualitative.

Page en double, l'URL envoyée n'a pas été sélectionnée comme URL canonique

Cette section ressemble au cas de figure “Page en double, Google n'a pas choisi la même URL canonique que l'utilisateur”. La différence ici est que vous avez envoyé l’URL via un fichier sitemap.

Les URLs présentes ici sont donc dans votre fichier sitemap et Google a jugé plus pertinent d’en indexer une autre.

Solution :

Etant donné que les URLs sont présentes dans le sitemap, il est important de vérifier chacune d’elles.

Si l’URL concernée est bien une page dupliquée qui ne doit pas être indexée, retirez-là de votre fichier sitemap et faites pointer l’URL canonique vers la version pertinente.

Dans le cas où l’URL n’est pas une page dupliquée mais bien une page unique, il est important de retravailler son contenu pour la rendre unique.

Bloquée en raison d'une interdiction d'accès (403)

Les URLs concernées n’ont pas pu être visitées car Google a l’interdiction d’y accéder.

Solution :

Si les URLs doivent être exclues de l’index, il est préférable d’appliquer une balise noindex ou de bloquer l’exploration via le fichier robots.txt.

Dans le cas où les URLs doivent être explorées et indexées, autorisez l’accès en affichant un code HTTP 200.

Bloquée en raison d'un autre problème de type 4xx

Lorsque Google a essayé d’accéder à ces URLs, il a rencontré des codes de réponses 4XX, différents de la 401, 403 et 404.

Solution :

Analysez les URLs avec l’inspecteur de la Search Console pour identifier le code HTTP.

Si les URLs sont importantes, corrigez le problème pour vous assurer que l’URL puisse s’indexer correctement.

Dans le cas contraire, vérifiez qu’aucun lien ne pointe vers ces URLs et mettez en place un blocage adapté.

Pour terminer cet article, vous aurez compris qu’il est crucial de bien configurer votre Search Console pour suivre attentivement ce rapport et vérifier la santé de votre boutique en ligne.

Dès que des erreurs apparaîtront sur votre site, vous pourrez recevoir une alerte par e-mail et réagir rapidement.

Bien entendu, même si Google Search Console (anciennement Google Webmaster Tools) est un outil proposé par Google, il arrive que certaines informations remontent avec du retard ou encore que vous rencontriez des données erronées. Il est donc important de toujours prendre son temps pour analyser les différents éléments et utiliser les fonctionnalités à votre disposition.

Pensez également à ajouter vos retours d’expérience en commentaire pour avoir le maximum de retours sur les différents cas énoncés ci-dessus !

Dominique Lemoine le 9 août 2023 à 23:44

Je voulais suivre vos conseils mais le souci est que je n'ai pas l'onglet couverture.

Y a t'il plusieurs versions de search console?

Merci pour votre retour.

Dominique

Xavier le 5 janvier 2024 à 09:54

Hytera MD618 le 5 avril 2024 à 06:54

Un guide essentiel pour maîtriser le rapport de couverture dans Google Search Console ! Avec des explications claires et des conseils pratiques, ce tutoriel vous aidera à comprendre et à corriger les erreurs éventuelles pour optimiser la visibilité de votre site web. Ne passez pas à côté de cette ressource précieuse pour améliorer votre présence en ligne. Prêt à booster votre référencement ? C'est par ici que ça se passe !