Parmi les leviers populaires du référencement naturel, l’analyse de logs est un sujet de plus en plus récurrent.

Souvent vu comme complexe pour les personnes sans connaissance technique, l’accès aux logs est également impossible sur l’ensemble des solutions e-commerce SaaS du marché.

Afin de renforcer notre volonté de proposer une solution e-commerce toujours plus optimisée pour le SEO, nous nous efforçons de rentrer en contact avec des grands acteurs du secteur. C’est pour cette raison que nous venons d’annoncer officiellement notre partenariat avec l’outil français Seolyzer !

La solution WiziShop est la 1ère plateforme SaaS au monde à rendre possible l’analyse de logs sur votre boutique en ligne pour travailler efficacement votre SEO.

Afin de vous présenter le logiciel et les différentes fonctionnalités qu’il propose, voici un guide complet. Cet article sera également mis à jour régulièrement en fonction des nouveautés proposées sur l’outil !

Présentation de Seolyzer

Lien vers l'outil : Seolyzer

Cet outil français développé depuis 2017 a pour objectif de rendre l’analyse de logs accessible à tous.

Les logs sont présents dans un fichier qui contient la totalité des appels (hits) au serveur. Lorsque des ressources se chargent sur une page (css, police, image, javascript,...), une ligne de log est générée pour chaque élément, directement dans le fichier de logs.

Le fichier se compose donc de nombreuses lignes représentant l’ensemble des hits générés sur votre site.

Au sein de ces hits se trouvent les visites des internautes mais aussi des robots des moteurs de recherche ! C’est à ce moment que ça devient intéressant.

Les bots des moteurs de recherche Google possèdent des adresses IP bien distinctes. Pour chaque hit, l’IP de la visite est indiquée dans le fichier. Est-ce que vous voyez où je veux en venir ?

Cet outil en ligne se charge du traitement des logs et fait reconstitue le parcours de Googlebot sur votre site !

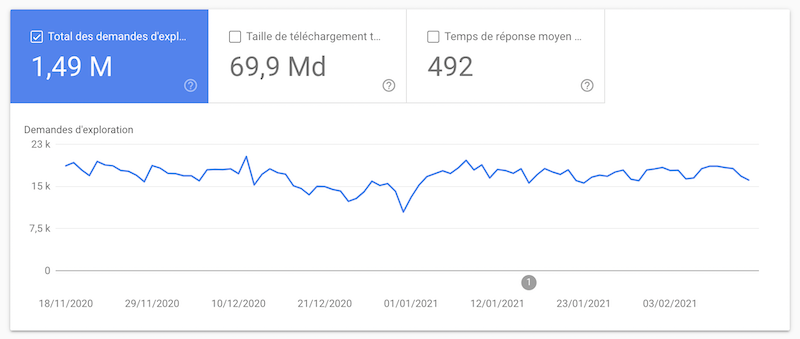

Ces données sont par ailleurs affichées dans la Search Console au niveau de l’onglet https://search.google.com/search-console/settings/crawl-stats.

À la différence d’un outil comme Seolyzer, elles ne sont pas en direct (quelques jours de retard) et ne comportent pas toutes les informations nécessaires à une bonne optimisation.

Voici en détail les fonctionnalités proposées par le logiciel et les différentes améliorations SEO que vous pouvez en ressortir.

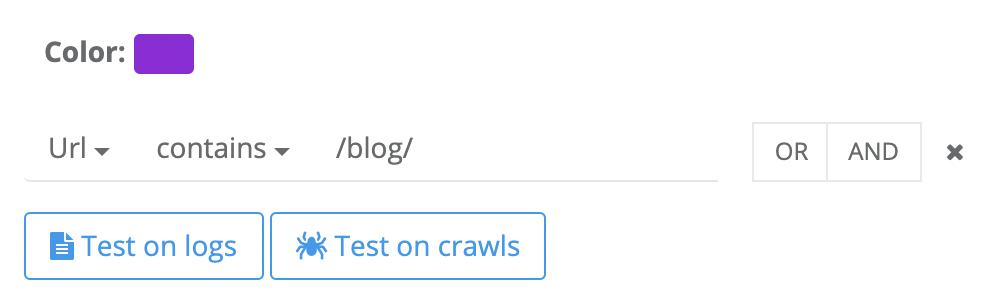

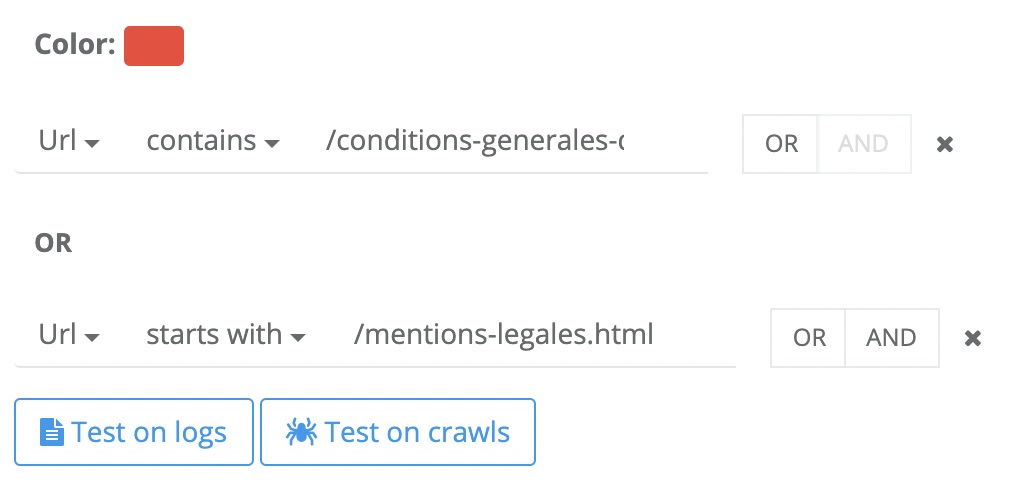

Page groups Setup

Cet élément est important à configurer puisqu'il vous permet de catégoriser les pages de votre site pour avoir une vision plus pertinente au sein de l’outil.

Vous pouvez, par exemple, créer des groupes pour vos produits, vos catégories, votre blog, vos contenus obligatoires (CGV, Mentions légales…), etc. Cette classification permettra ensuite de détecter le passage du robot sur chacune des sections de votre boutique.

L’outil propose également la création de sous-catégories pour affiner davantage.

Exemple classification blog :

Exemple classification CGV et Mentions Légales :

Crawler

Comme tout bon outil SEO qui se respecte, la fonction crawl est un indispensable !

Le processus de crawl représente l'exploration des différentes pages et éléments de votre site web par les robots des moteurs de recherche ou par des outils.

Cette section permet donc de lancer un crawl de votre site, à partir d’une URL de départ.

Cette fonctionnalité est très appréciée pour explorer toutes les URLs de votre boutique en ligne et ressortir des informations clés et des points à corriger.

L’intérêt supplémentaire de cet outil est que vous pouvez ensuite croiser vos résultats avec vos logs. Ce croisement permet, entre autres, de ressortir vos pages orphelines ou encore inactives. Je vous en parle un peu plus tard dans l’article !

Au sein de cette section, vous allez retrouver différents outils :

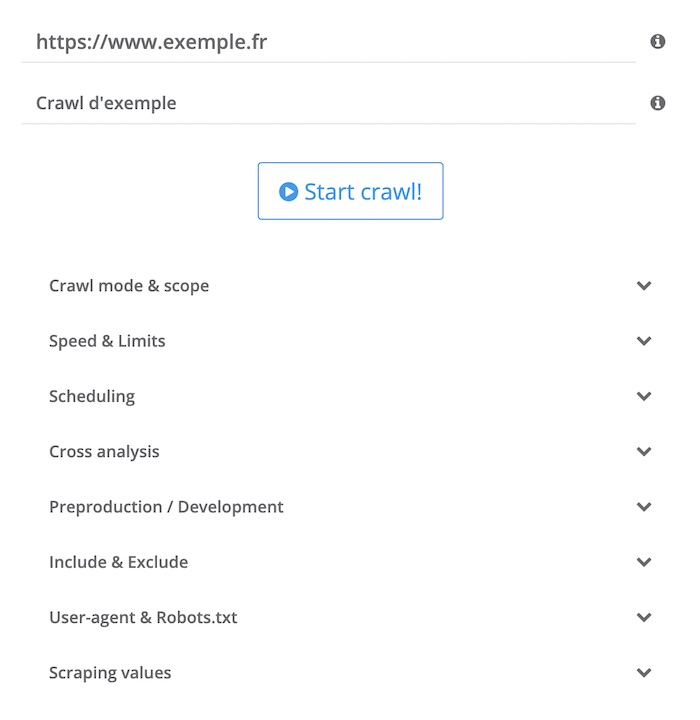

Crawl List

C’est ici que vous pouvez lancer votre crawl et définir la configuration (vitesse de crawl, planification, domaine et sous-domaine, user-agent, etc).

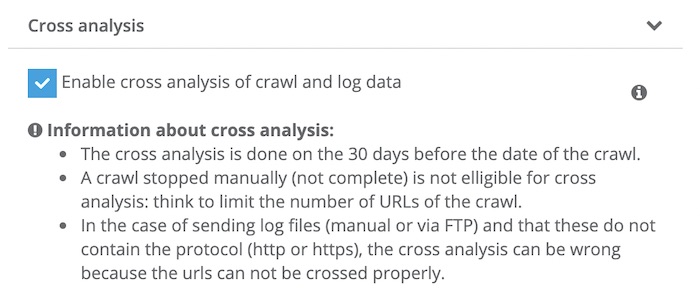

La fonctionnalité importante que je vous conseille d’activer une fois que l’outil a récupéré des données issues des logs est : “Cross Analysis”.

Indexability

Dans la section “Indexability”, vous allez pouvoir découvrir l’ensemble des URLs parcourues et découvrir de nombreuses analyses pertinentes.

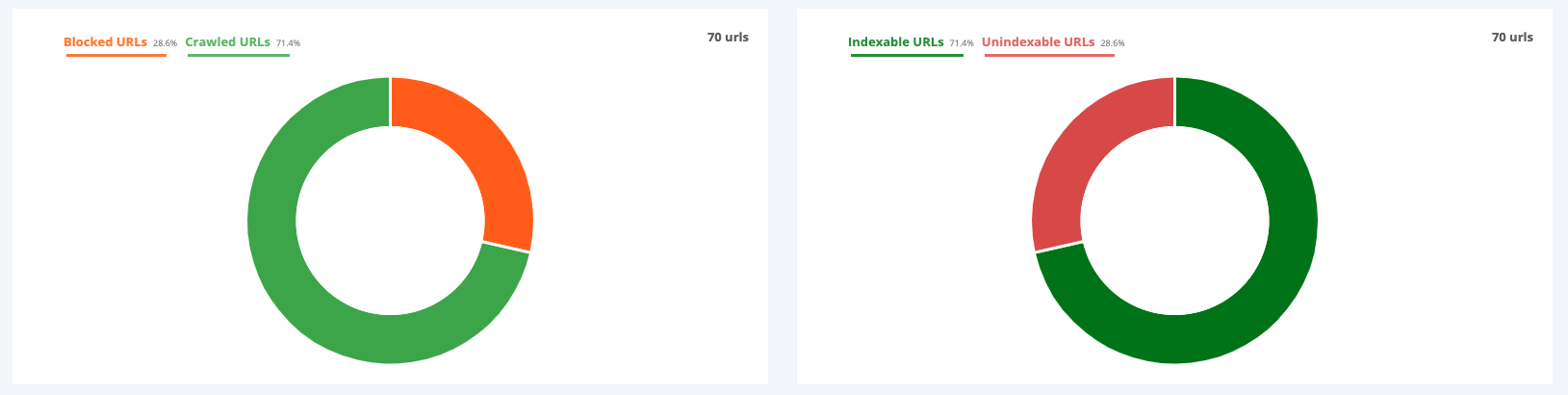

- Dashboard

Sur le graphique de gauche, vous pouvez découvrir le pourcentage d'URLs dont l’accès est bloqué pour les moteurs de recherche sur votre site (Blocked URLs). Elles apparaissent dans cette section car elles sont, la majorité du temps, bloquées via le fichier robots.txt de votre site.

Vous disposez également du pourcentage d'URLs autorisées au crawl (Crawled URLs).

Sur le graphique de droite, ce sont les URLs qui ne peuvent pas être indexées par les moteurs de recherche (Unindexable URLs). Elles comprennent celles bloquées via robots.txt mais également celles qui contiennent, par exemple, une balise noindex, des codes HTTP en erreur, une canonical qui pointe vers une autre page, etc.

Et enfin, les URLs indexables (Indexable URLs).

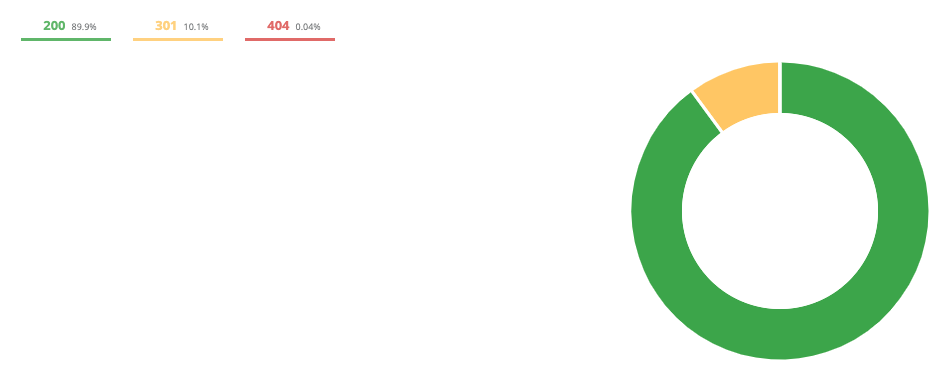

- HTTP Codes

Cet onglet met en avant l’ensemble des codes HTTP rencontrés (301, 404, 200, 500,..).

L’étude des codes HTTP vous permet de détecter facilement les liens en erreurs au sein de votre boutique pour les corriger.

Sur l’exemple ci-dessus, la majorité (89,9%) sont en code 200, ce qui est un bon résultat. En revanche, pour les codes 301 et 404, il va falloir vérifier les URLs pour apporter des corrections.

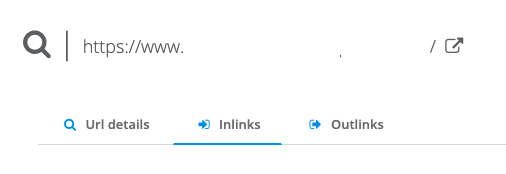

Lorsque vous détectez une 301 par exemple, il vous suffit de cliquer sur l’URL :

Un panneau de détail de l’URL s’affiche, il vous suffit ensuite d’accéder à “inlinks” pour découvrir les liens pointant vers cette page afin de les corriger.

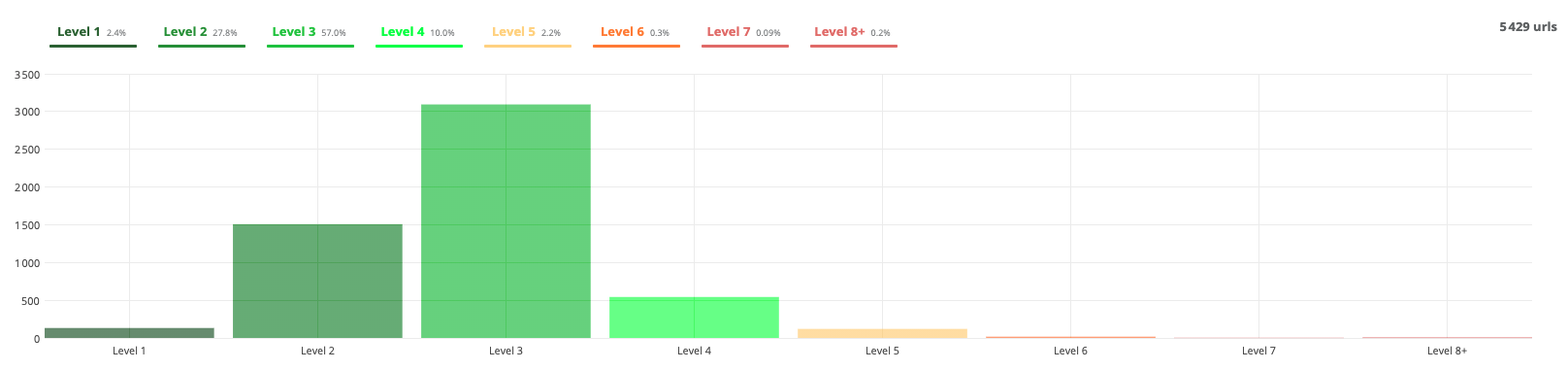

- Depth

La profondeur d'une URL représente le nombre de clics depuis l’accueil pour y accéder.

Sur un site e-commerce, entre les catégories, sous-catégories et la pagination, des contenus peuvent rapidement se retrouver à des profondeurs importantes. Ceci engendre fréquemment des problématiques liées à une perte de puissance.

Sur cet exemple, il y a 8 niveaux de profondeur. Ce qui signifie que certains contenus sont accessibles à 8 clics de l’accueil !

Il faudrait donc penser à les rapprocher pour arriver à environ 3-4 clics.

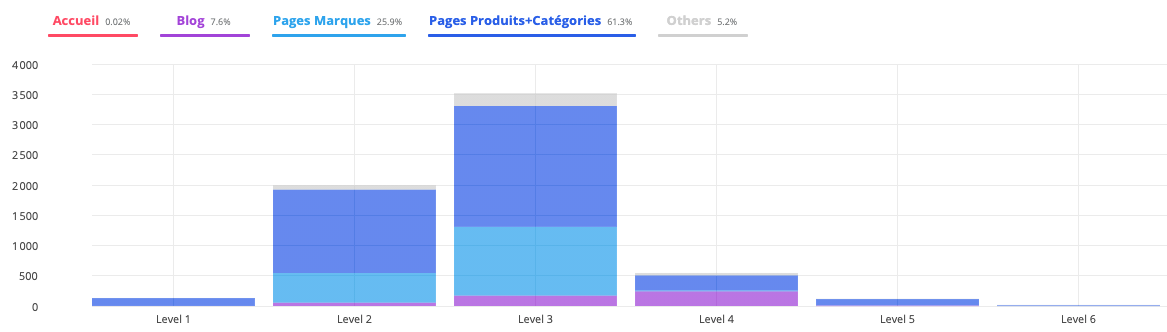

- Depth by group

Cet onglet est similaire à celui précédent mais il reprend votre configuration “Page groups setup”.

Il vous permet de détecter quelles sont les parties du site qui sont trop profondes. Est-ce que ce sont plutôt des articles de blog, des fiches produits, des sous-catégories,...?

Ces analyses sont très pratiques pour détecter les pages à faible puissance et, si besoin, mettre en place des corrections, telle qu’un maillage plus proche de la page d’accueil.

- Structures URLs

L’onglet “Structures URLs” répertorie l’ensemble des URLs détectées sur le site lors du crawl.

- Crawled URLs, Indexables URLs, Unindexable URLs, Blocked URLs

Les onglets suivants reprennent, en détail, les graphiques que nous avons détaillé dans la partie “Dashboard” et listent les différentes URLs concernées.

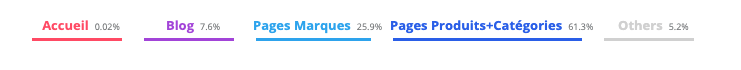

- URLs group

Enfin, l’onglet “URLs group” reprend les différents groupes que vous avez créés dans “Page groups setup”.

Cet onglet vous permet de détecter, en un clin d'œil, le volume de chaque catégorie en pourcentage selon vos filtres.

Par exemple ici, mes fiches produits et mes catégories représentent 61,3% des URLs découvertes sur ma boutique par le crawl.

Content

L’onglet “Content” permet d'étudier les éléments liés au contenu lors du crawl.

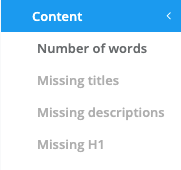

- Number of words

Ici, vous pouvez facilement détecter le pourcentage en fonction du nombre de mots dans votre site.

Par exemple, ici, on remarque que la majorité possède entre 1000 et 1500 mots, ce qui est un très bon indicateur.

Si votre site possède majoritairement des pages entre 0 et 500 mots, il peut être intéressant de travailler vos textes car vous n’exploitez pas pleinement votre potentiel SEO.

Attention, il n'existe pas de règle exacte concernant le nombre de mots nécessaires dans votre contenu pour se positionner. C’est au cas par cas que vous devez analyser vos textes ainsi que vos positions et vérifier si l’optimisation de votre contenu est une bonne idée.

- Missing titles

Le Title est une des balises les plus importantes en SEO.

Si l’outil détecte un Title manquant, il est fort possible que vous devez l’ajouter pour mieux positionner votre contenu dans les moteurs de recherche.

- Missing descriptions

La meta description n’a pas d’impact direct sur le ranking mais il est dommage de ne pas la renseigner car elle permet d’inciter les internautes à cliquer sur votre site dans les pages de résultats (CTR).

Si certaines descriptions ne sont pas présentes, pensez à les rajouter !

- Missing H1

Comme pour la balise Title, le H1 est important. Ce titre doit être présent pour assurer un bon positionnement de votre page.

Attention car il se peut que l’outil retourne des balises H1 manquantes sur la pagination de vos catégories produits ou de votre blog. Cette absence de balise est volontaire sur notre solution afin de les désoptimiser.

- Title, description & H1 duplicates

Cet ajout récent dans l’outil vous permet d’identifier des balises dupliquées au sein de votre site.

Le résultat, sous forme de graphique, vous affiche le nombre de balises dupliqués, le nombre de balises manquantes ainsi que le nombre de balises uniques.

Links

L’onglet “Links” permet de ressortir les pages les plus puissantes de votre site en fonction de votre maillage interne.

Selon le nombre de fois où les liens sont présents sur votre boutique, l’outil va vous donner une estimation simplifiée du PageRank interne.

Si vous remarquez que la plupart de vos pages avec le PageRank le plus élevé sont peu intéressantes pour le SEO (CGV, contact, panier, etc), il se peut que vous ayez des optimisations à faire !

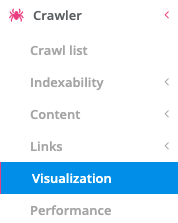

Visualization

Le logiciel vous fournit également une visualisation spatiale de la structure de votre site en reprenant votre maillage interne.

Le graphique met sous format visuel le PageRank (taille des noeuds du graphique), la profondeur des pages, les URLs en noindex, etc.

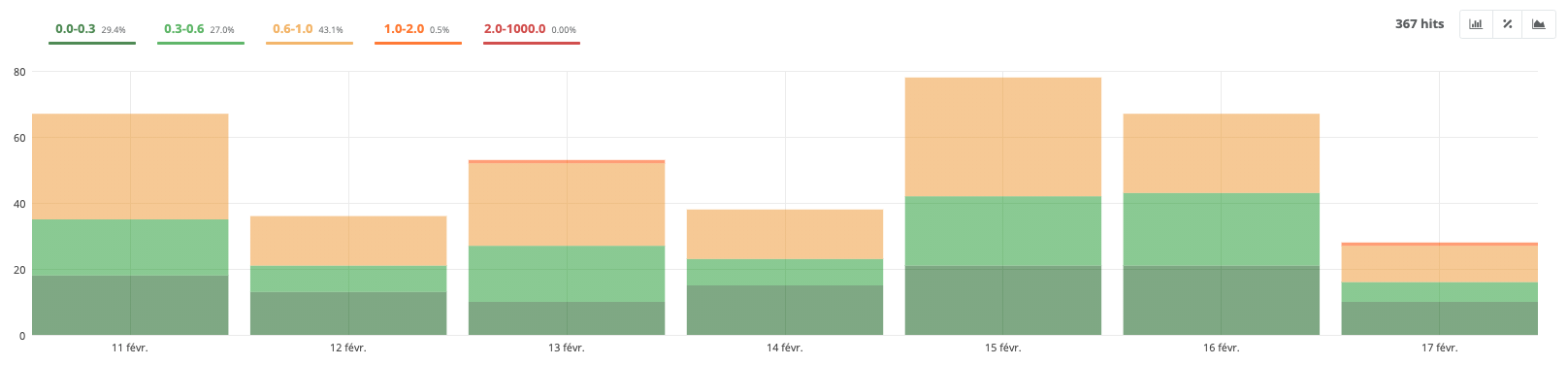

Performance

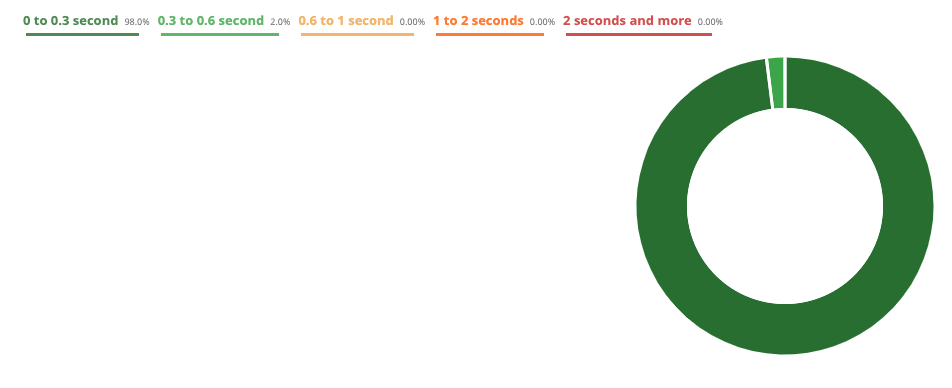

Enfin, l’onglet “Performance” indique le temps de réponse des différentes URLs parcourues lors du crawl.

Ce rapport vous permet de ressortir les différentes pages de votre site peu performantes au niveau de la vitesse de chargement afin de corriger le tir et améliorer ce critère technique.

Le graphique nous indique donc dans cet exemple que la majorité des pages sont rapides à charger (entre 0 et 0,3 secondes pour 98%).

Lorsque vous analysez votre page, pensez à utiliser l’outil de Google https://developers.google.com/speed/pagespeed/insights/ pour détecter ce qui ralentit votre page et trouver des opportunités d’amélioration. Il est fréquent de retrouver des scripts ou encore des images trop lourdes.

Crawl Evolution

Cette partie est similaire à la partie “Crawler”. Sa grande différence est, comme son nom l’indique, qu’elle permet de comparer plusieurs crawl entre eux.

Par exemple, si vous travaillez sur la correction d’éléments comme les codes HTTP 404 ou encore la profondeur, vous pouvez ensuite relancer un nouveau crawl et le comparer à l'ancien.

Cette analyse est très pertinente pour visualiser efficacement vos corrections et vos optimisations.

Voici quelques exemples :

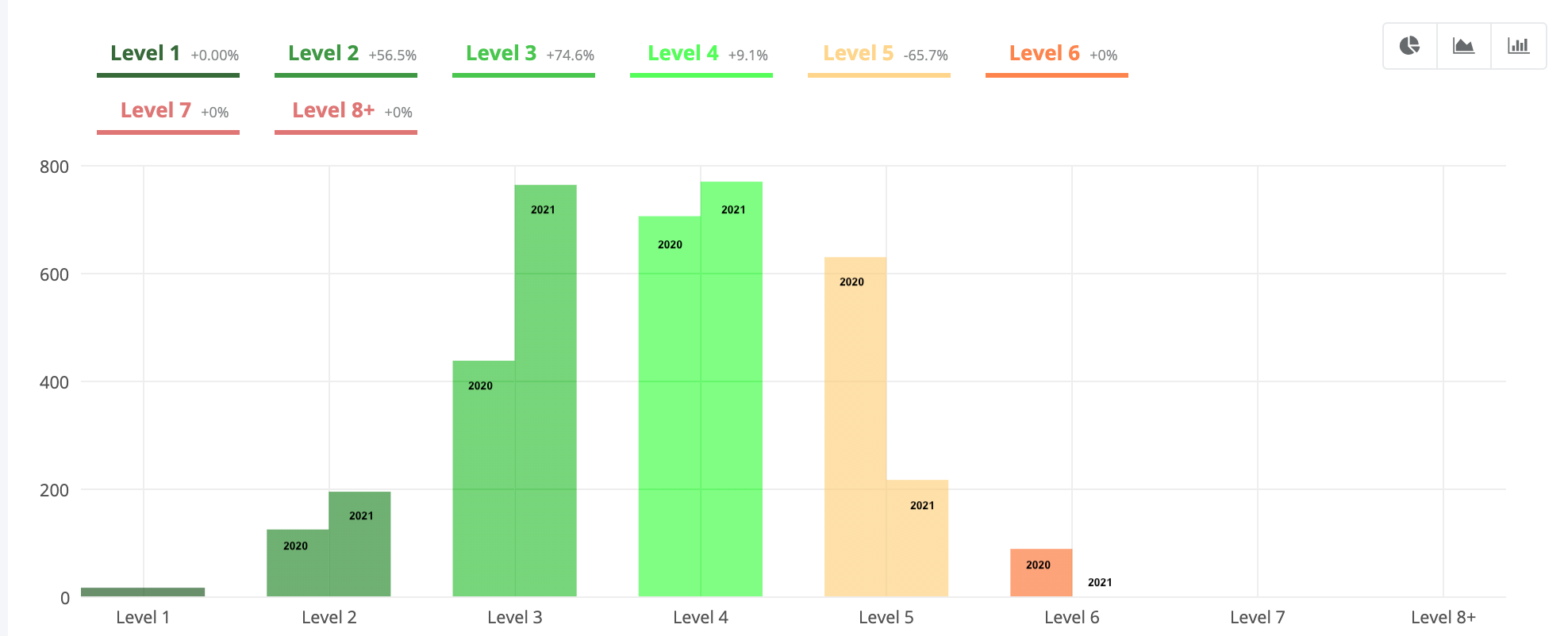

- Section “Depth”

Ici, on remarque qu’un travail de réduction de profondeur a été fait sur le site entre 2020 et 2021.

La majorité des pages du site ont été rapprochées de l’accueil. Il n’existe plus de pages à 6 clics de la page d'accueil, il y en a beaucoup moins à 5 clics et logiquement il y en a plus au niveau 2, 3 et 4.

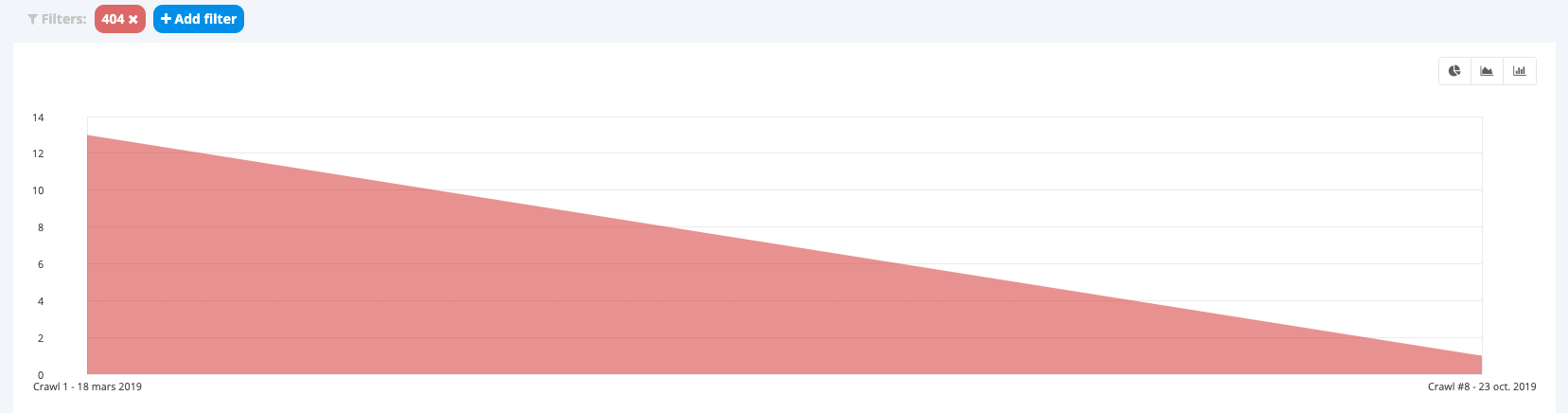

- Section “HTTP Codes”

Sur cet autre exemple, le site est passé de 13 erreurs 404 lors du premier crawl à 1 lors du second. 92% des codes HTTP 404 ont donc été corrigés.

Vous pouvez comparer tout un tas d’autres éléments comme les URLs indexables, le nombre de mots, le temps de chargement, etc.

- Sections « Links »

Cet onglet vous permet de comparer votre nombre moyen de liens entrants par type de page, sur plusieurs crawls.

Par exemple, si vous réduisez le nombre de liens entrants vers une section de votre site, sans intérêt pour le SEO, la comparaison avec un ancien crawl vous permettra d’identifier rapidement la diminution du nombre de liens entrants.

Vous pourrez donc rapidement comparer l’ancien nombre de liens avec le nouveau.

- Section “Cross analysis”

Enfin, petite particularité de l’outil et pas des moindres, la section “Cross analysis”.

Si vous avez activé la case “Cross analysis” lors du lancement de vos crawl, vous pouvez ici comparer les informations récupérées depuis le crawl Seolyzer mais également de Googlebot tout en comparant 2 analyses différentes.

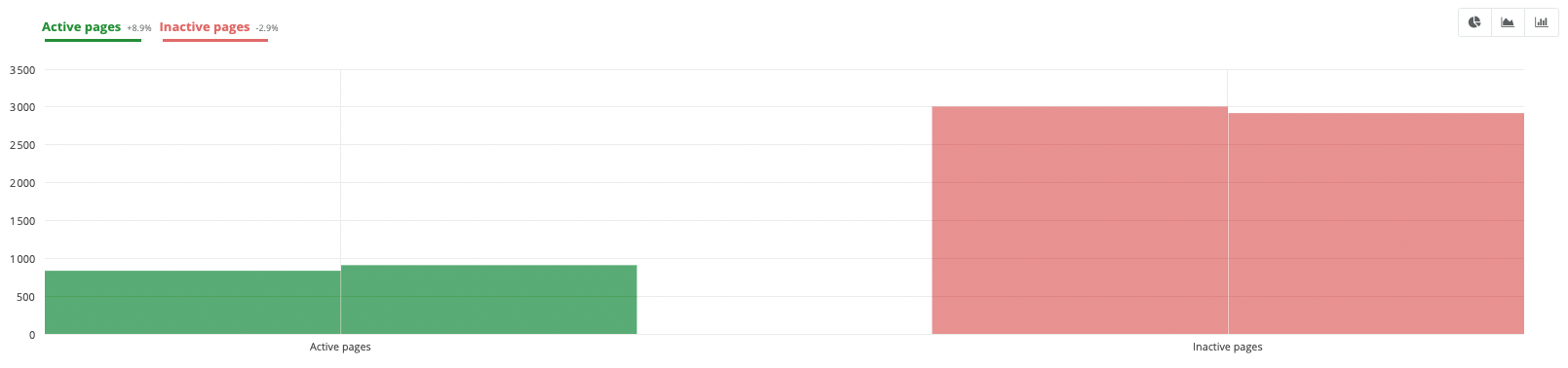

Par exemple, ici, la comparaison de 2 crawls différents permet de mettre en évidence qu’il y a maintenant plus de pages actives sur le site et moins d’inactives. Un travail d’optimisation a sûrement été réalisé après le premier crawl.

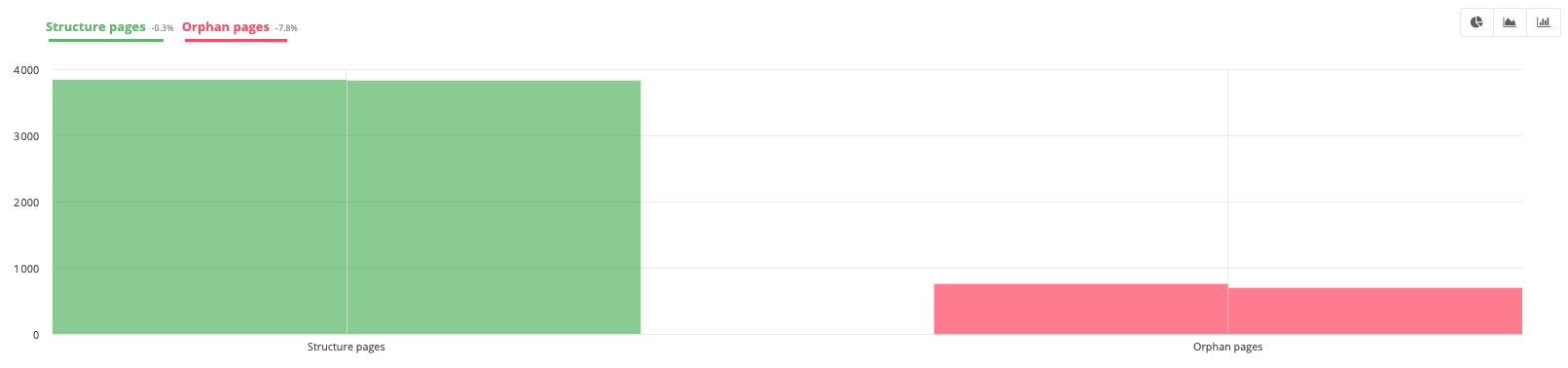

Autre exemple avec la section “Orphan Vs Structure”, le pourcentage de pages orphelines a diminué entre les 2 analyses. Celles présentes dans la structure sont elles restées à peu près égales. Ce qui signifie que la personne a peut-être supprimé des pages orphelines suite à la 1ère analyse.

Log Analysis

Nous arrivons ensuite dans la fonctionnalité historique de l’outil : l’analyse de logs.

C’est ici que vous allez pouvoir étudier le comportement des robots des moteurs de recherche sur votre boutique.

Googlebot

Cet onglet est dédié au suivi du robot de Google sur votre site. Son comportement n’aura plus aucun secret pour vous après avoir découvert cette section !

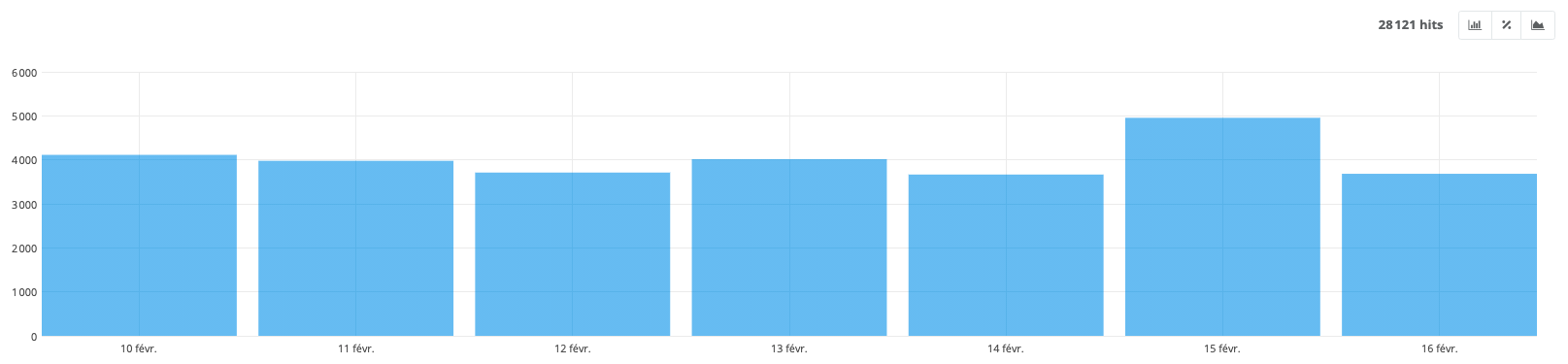

- Crawl volume

Cet onglet recense nombre de pages consultées par le bot de Google avec une granularité au choix : par mois, semaine, jour, heure...

Ici, vous remarquez sur ce site que le robot de Google consulte environ 4000 URLs par jour. Plus votre site est puissant et volumineux, plus le passage des bots sur votre site sera intensif.

Voici, par exemple, un site lancé durant l’année 2020 :

On voit clairement que le passage augmente petit à petit avec le temps.

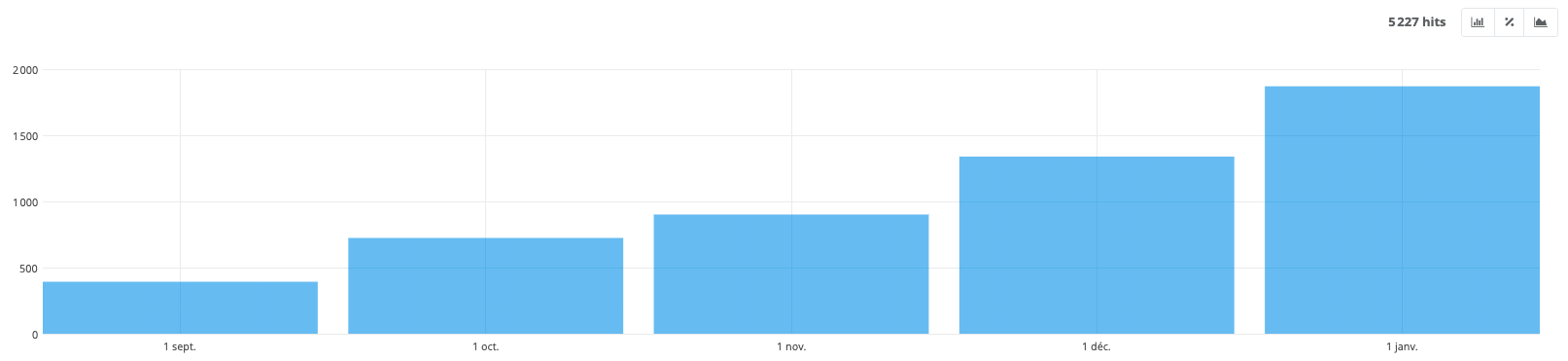

- Crawl volume by group

Comme pour les sections qui représentent les groupes que vous avez configurés, vous pouvez découvrir, ici, les catégories.

C’est une partie très intéressante puisqu'elle permet de vérifier si le robot a la même vision de votre site que vous.

Cet exemple ci-dessus nous montre que la majorité est focalisée sur les catégories et produits du site. Ce qui est, à priori, une bonne chose puisque ce sont des sections du site qui génèrent directement du chiffre d’affaires.

En revanche, si dans votre analyse, vous remarquez que la plupart de vos URLs crawlées concernent des sections inintéressantes de votre site, il peut être judicieux de mettre en place des corrections pour redistribuer efficacement le crawl.

Par exemple, sur un e-commerce techniquement mal configuré, la majorité des passages peut se faire sur les filtres à facette ou les tris.

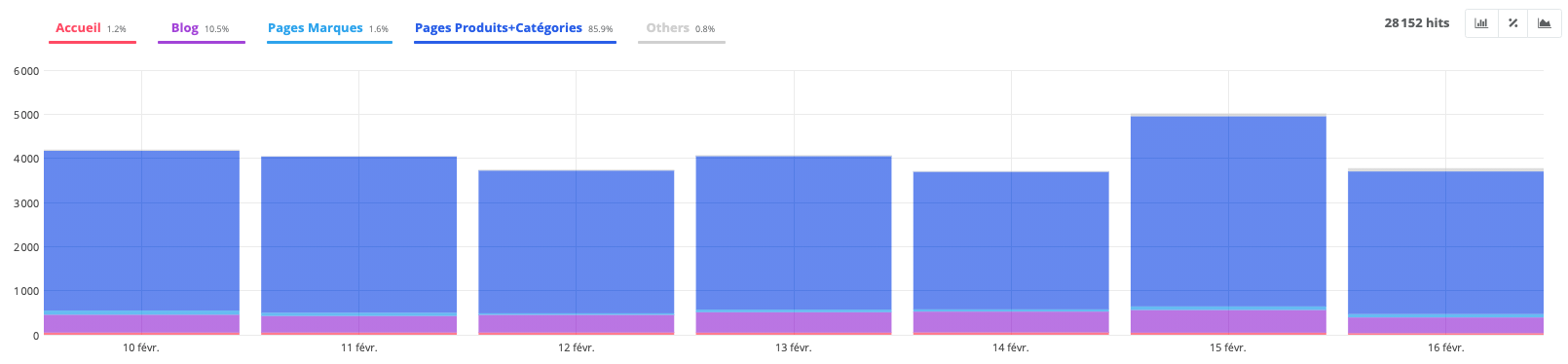

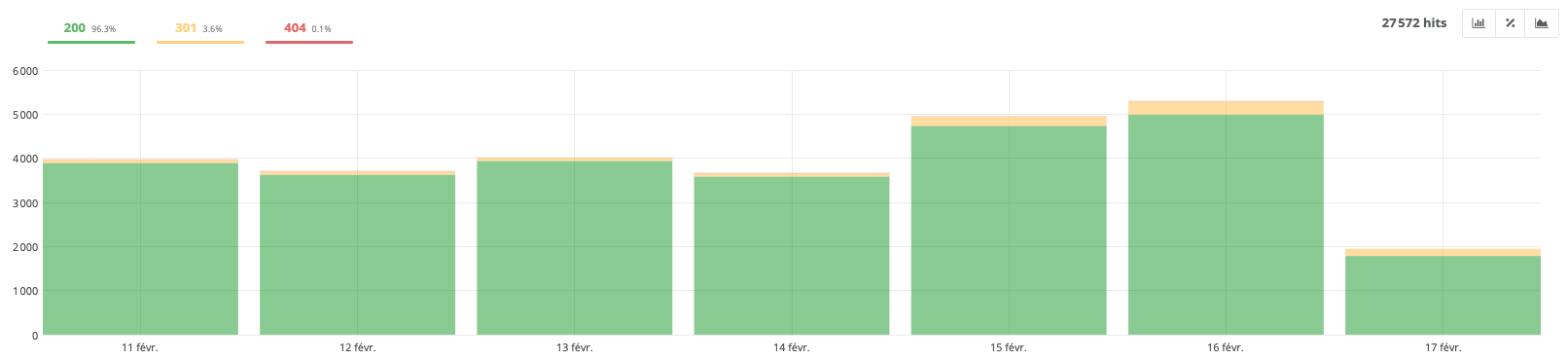

- HTTP status code

Comme pour le rapport de la partie “Crawler”, celui-ci indique les codes HTTP rencontrés par le bot.

Sur cet exemple, la majorité du site répond en 200, ce qui est un bon indicateur. Il faudrait simplement vérifier les différents codes 301 et 404 pour corriger, éventuellement, les pages qui y mènent.

Il est fort possible que sur ce rapport, vous rencontriez des données différentes de celles du crawler. Google parcourt l’ensemble des pages qui ne sont pas forcément présentes dans votre site à un instant T, car il détient un historique.

Par exemple, si vous avez mis en place des redirections, si vous avez supprimé des URLs ou si vous possédez des backlinks pointants vers des pages inexistantes, etc, il est fort possible que le robot les visite régulièrement. Il peut donc y avoir diverses raisons qu’il vous faut étudier minutieusement.

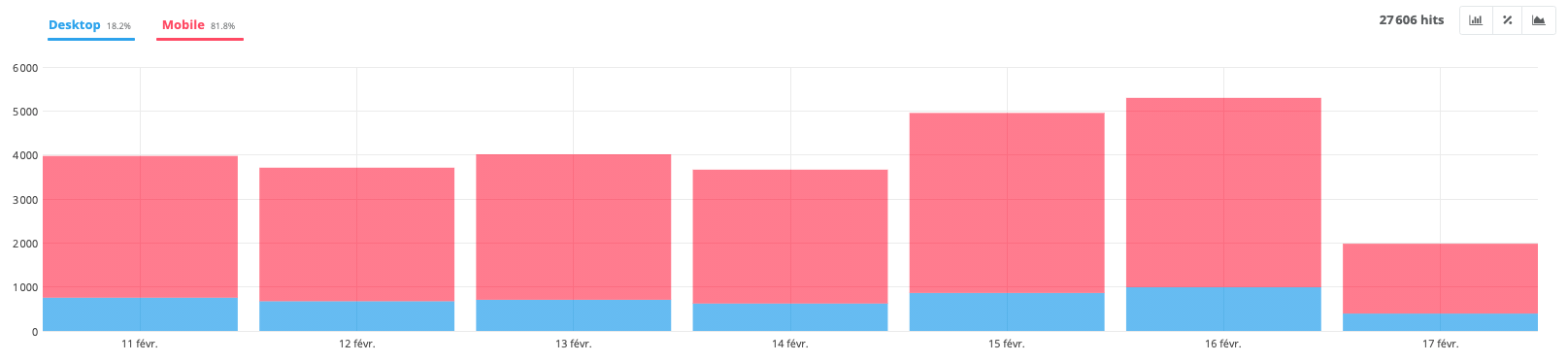

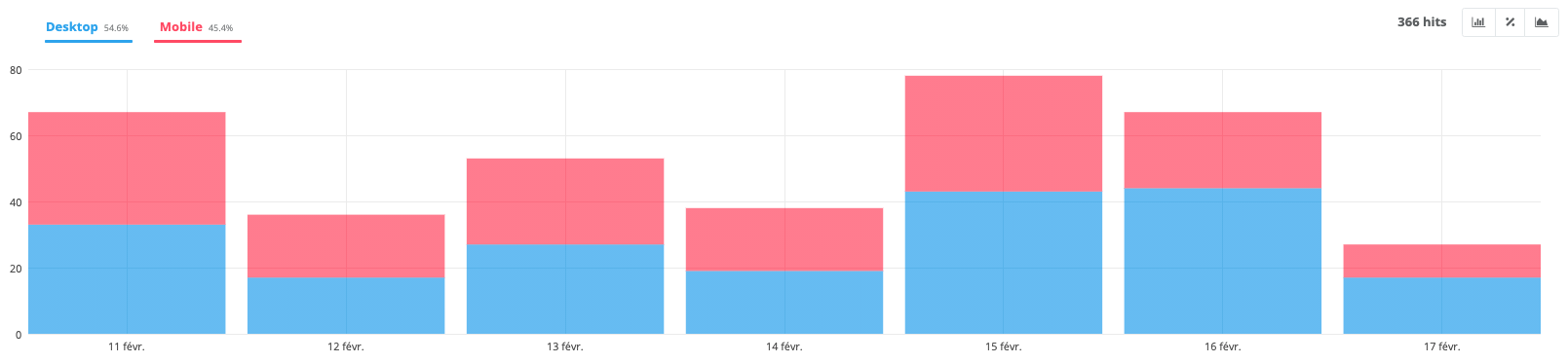

- Desktop vs Mobile

Cette partie permet de découvrir la répartition selon le mobile et desktop.

Naturellement, avec l’importance du mobile et le déploiement du mobile-first, le crawl tend à se focaliser majoritairement sur le mobile.

Sur cet exemple, c’est un site e-commerce qui possède la version AMP. Il est également passé en mobile-first, ce qui favorise grandement le passage du robot mobile.

Sur cet autre exemple, le mobile-first n’est pas encore déployé. Le ratio entre mobile et desktop est quasiment égal avec un pourcentage un peu plus élevé de desktop.

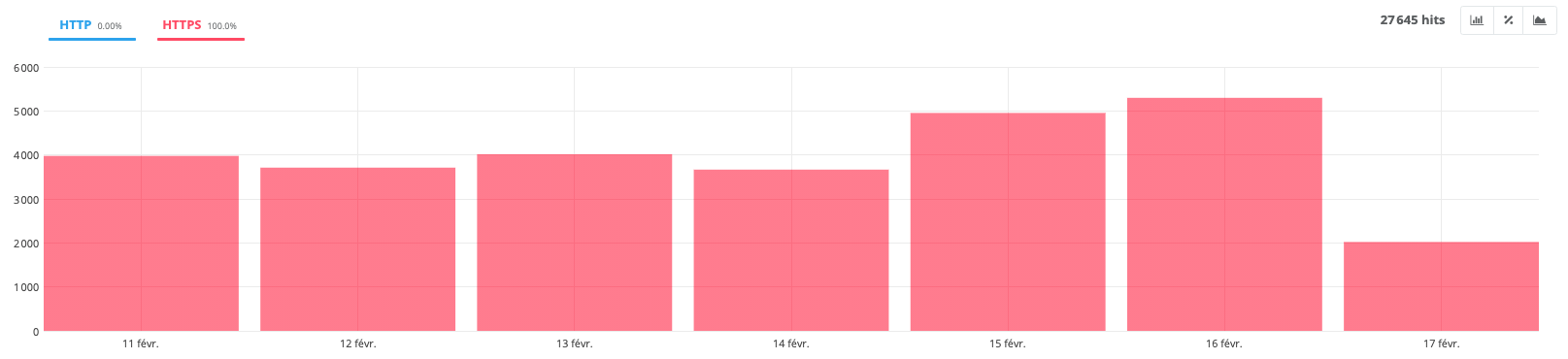

- HTTP vs HTTPs

Le rapport HTTP vs HTTPs vous indique si le robot parcourt des pages sécurisées ou non sécurisées sur votre site.

En règle générale, si votre configuration est bonne et que vous lancez un site en HTTPs, il ne devrait pas y avoir de souci.

Lors d’une migration de HTTP à HTTPs, ce rapport peut-être très utile pour vérifier le passage à la nouvelle version.

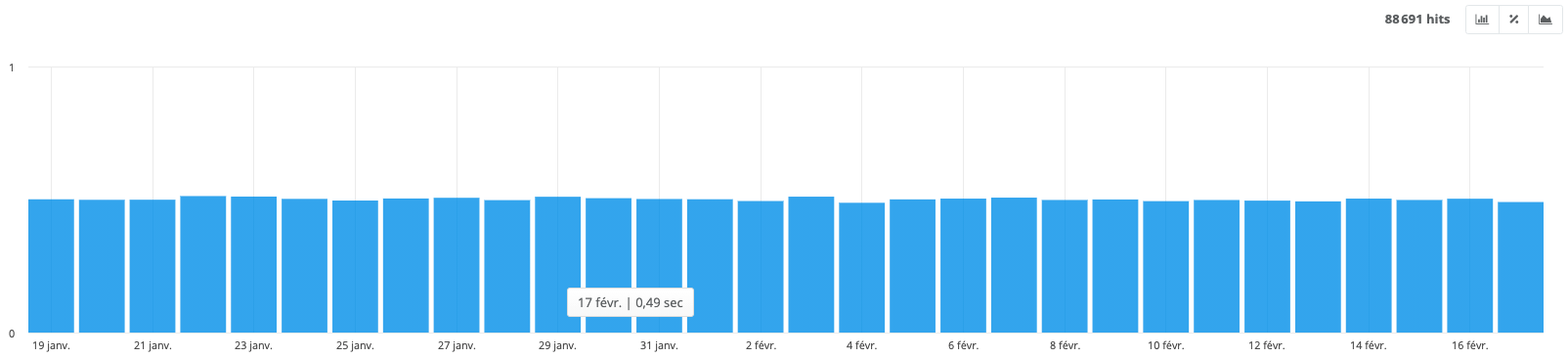

- Avg performance

Cette section met en avant le temps de réponse moyen par page lors du passage du bot. Ce temps de réponse représente le temps que le serveur met à générer la page et à envoyer le 1er octet. Il arrive juste un peu avant le TTFB (Time To First Byte) qui comprend en plus le temps de transfert réseau.

Sur cet exemple, le temps de réponse moyen des URLs du site est de 0,49 secondes le 17 février. Sur les autres jours, le temps de réponse est assez similaire.

- Performance

Cet onglet vous fournit le détail du temps de réponse, URL par URL.

Par exemple, en cliquant sur la partie avec un temps de chargement “1,0-2,0”, vous pouvez découvrir le détail avec les différentes URLs qui sont assez longues à charger.

- Most crawled

“Most crawled” est un autre onglet important de l’outil. Il classe par nombre de visites du Googlebot toutes celles explorées.

Vous pouvez rapidement analyser les endroits où le robot se focalise. Comme pour l’onglet “Crawl volume by group”, il faut étudier minutieusement le rapport pour vérifier si tout semble pertinent.

Par exemple, si votre accueil et vos produits / catégories sont les plus crawlés, c’est une bonne chose. En revanche, si vos top pages crawlées sont les CGV ou encore une page intéressante pour le SEO, il peut-être intéressant de mettre en place des améliorations.

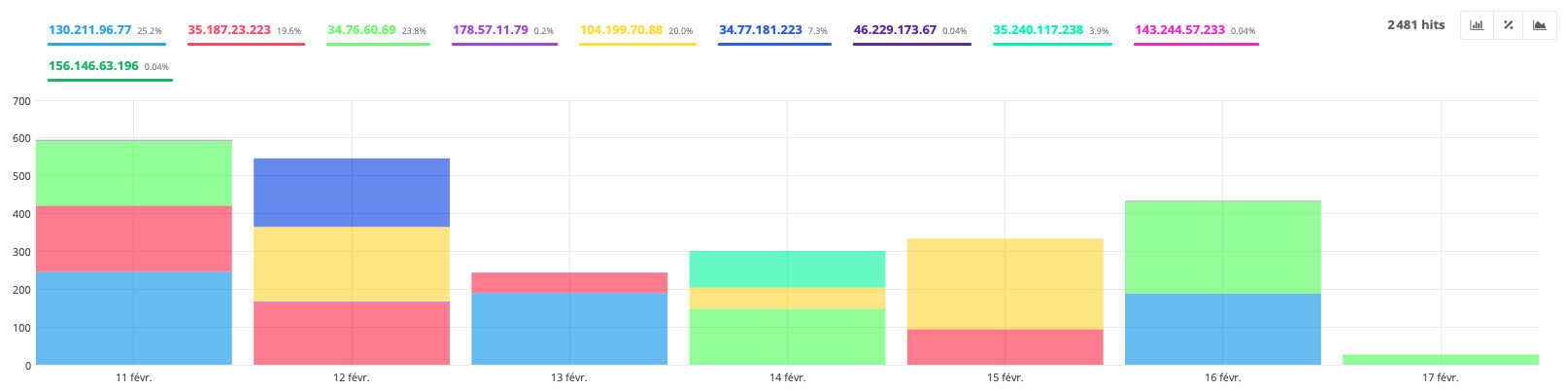

- Bad bots

Les “Bad bots” sont des bots qui se font passer pour Google. Les “mauvais” bots peuvent avoir comme objectif de récupérer des données, de spammer des formulaires ou autres activités malveillantes.

Vous allez voir qu’il y en a bien plus souvent que ce que vous pensez qui passent sur votre site !

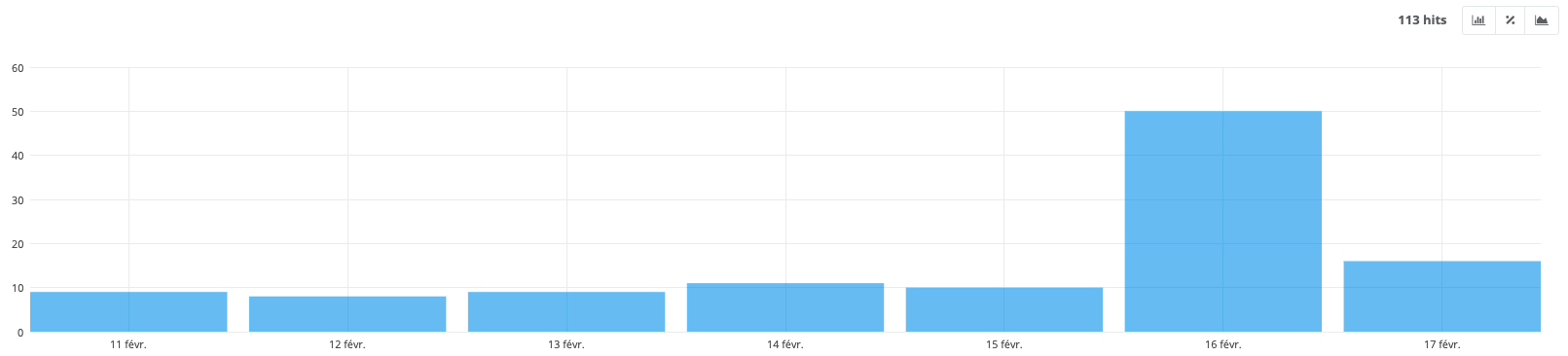

- New URLs

Cette section vous permet d’identifier les URLs crawlées pour la première fois par le bot.

Si vous créez de nouvelles pages sur votre site, vous allez rapidement les identifier dans ce rapport.

Par exemple, ici, le rapport affiche que 113 nouvelles URLs ont été découvertes au cours des 7 derniers jours. C’est un e-commerce, le rythme d’ajout des fiches produits et de contenu est donc assez soutenu.

- Bandwith

Cet onglet permet d’afficher la bande passante utilisée par Googlebot. Elle est uniquement dédiée à une installation sur serveur dédié Apache ou Nginx. Si vous êtes sur un serveur mutualisé, vous n’aurez donc aucune donnée à ce niveau.

Visitor

La partie “Visitor” est dédiée aux visites “réelles” d'internautes sur votre site. Plusieurs sections sont disponibles pour vous fournir une vue précise et détaillée. Ces rapports permettent de compléter ceux disponibles sur Google Analytics.

- SEO visits

Ce premier rapport affiche le nombre de visiteurs qui proviennent des moteurs de recherche.

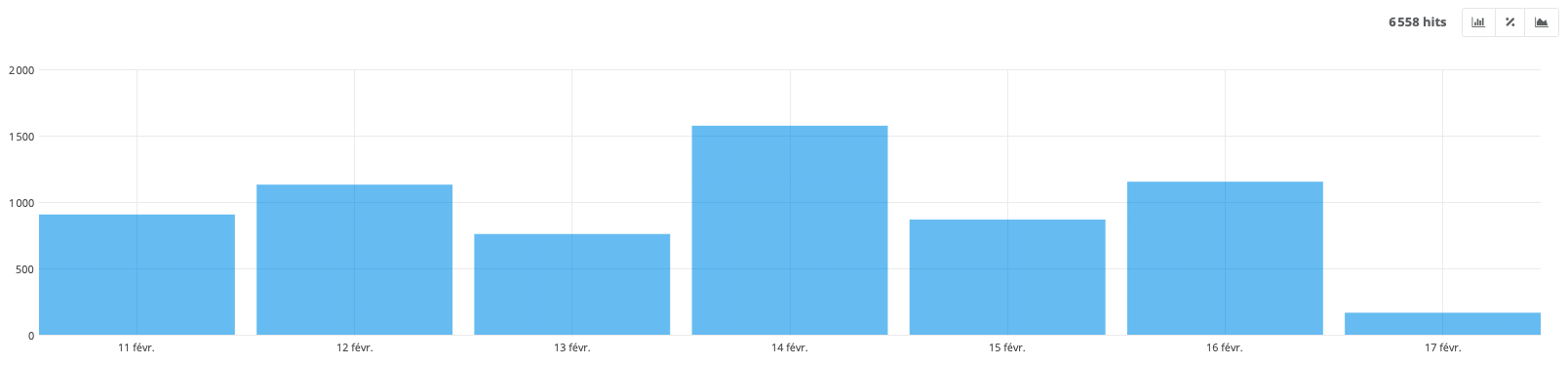

Par exemple, ici, durant les 7 derniers jours, 6558 visiteurs se sont rendus sur le site e-commerce via le levier naturel SEO.

- SEO visits by groups

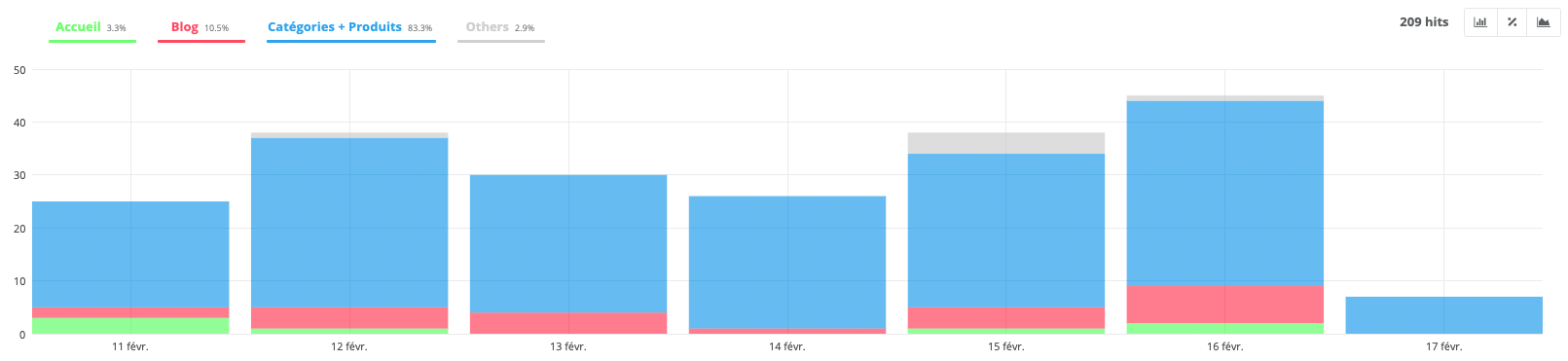

Cet onglet permet de mettre en avant les groupes sur votre site qui génèrent le plus de visites et ceux qui en génèrent le moins.

L’exemple, ci-dessus, nous indique que 83,3% du trafic SEO arrive sur les catégories et produits, 10,5% sur le blog et 3,3% sur l’accueil, ce qui est plutôt un bon indicateur.

En e-commerce, les pages business sont les fiches produits et les catégories. Avoir une majorité de trafic sur cette partie du site est intéressant pour générer du chiffre d’affaires !

- Most visited

Tout comme l’onglet “Most Crawled”, vous pouvez découvrir ici les pages classées par nombre de visites SEO.

- SEA visits

L’onglet “SEA visits” affiche vos visiteurs qui proviennent de la publicité en ligne, générée avec Google Ads.

Bien entendu, si vous ne réalisez pas de publicités sur votre site, ce rapport sera vide.

- Active pages

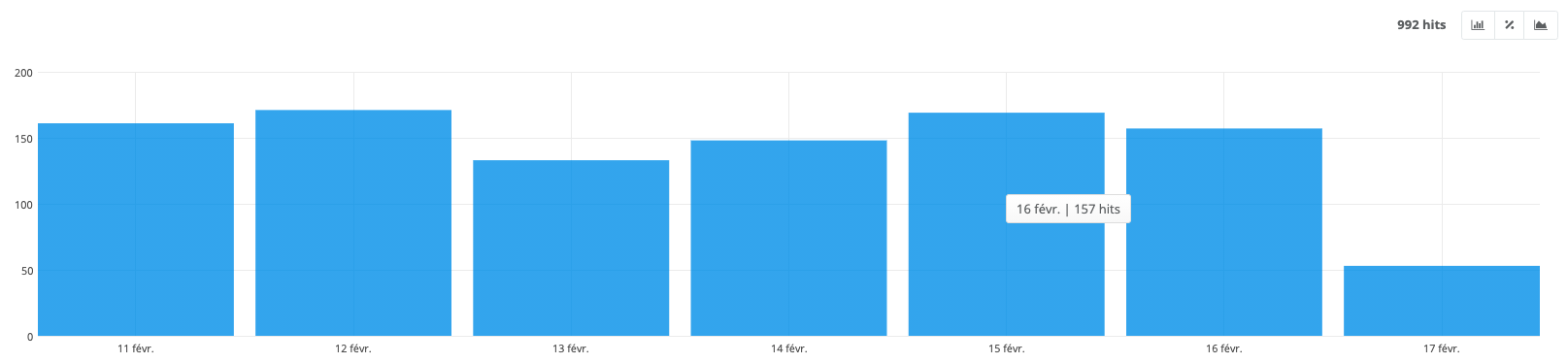

Les pages actives sont représentées par celles qui génèrent au moins une visite SEO.

Par exemple, le rapport, ci-dessus, m’indique que le 16 février, le site a eu 157 pages qui ont généré au moins une visite SEO.

- Active pages by groups

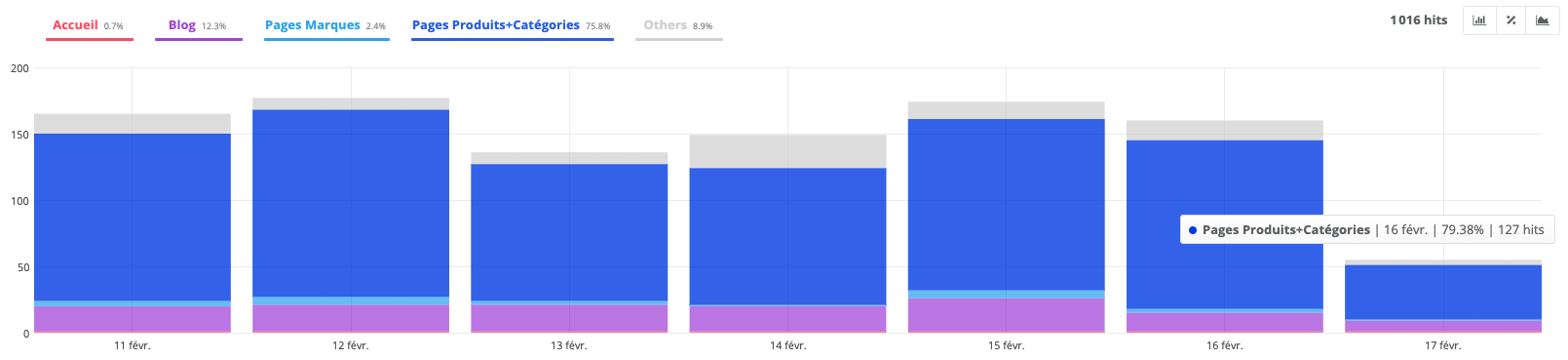

Toujours via le système de groupement, ce rapport affiche les résultats cités ci-dessus avec une vue “groupe”.

Je peux donc facilement identifier que le 16 février, sur les 157 pages qui ont généré, au moins, une visite SEO, 79,38% d'entre elles sont des catégories et produits.

All logs

Enfin, cet onglet recense l’ensemble des visites de Googlebot, du SEO et du SEA.

Cross Analysis

Une des dernières parties intéressantes de l’outil : Cross Analysis.

Cet onglet permet de coupler les différentes données du crawl et des logs pour ressortir des analyses très fines de votre site.

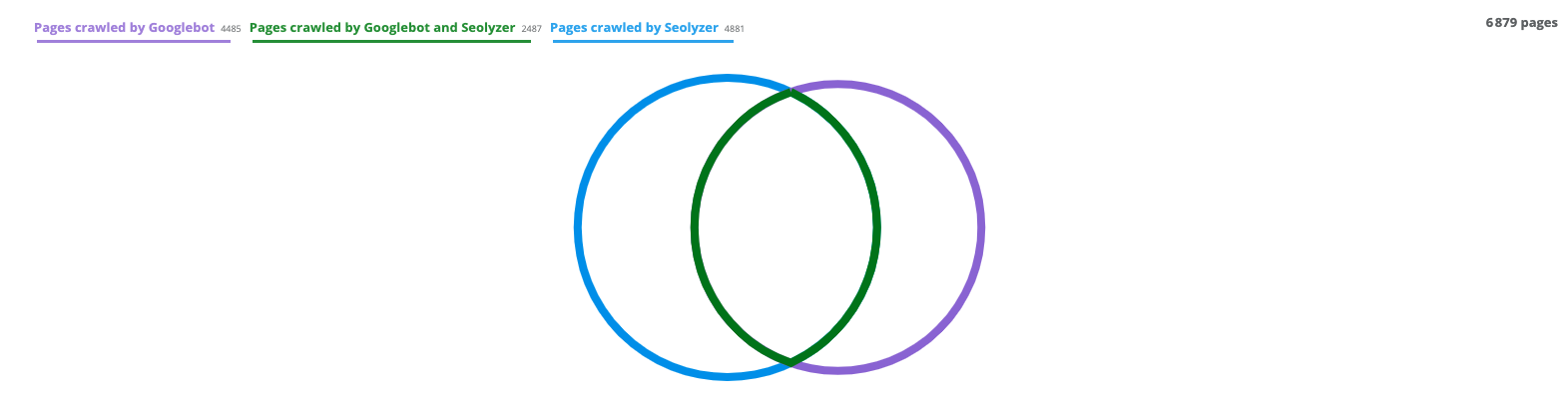

- Dashboard Graphique n°1

La première section du dashboard met en avant les pages crawlées par Googlebot, celles crawlées par Seolyzer et enfin, celles que Googlebot et Seolyzer ont crawlées.

Sur l’exemple ci-dessus, on remarque assez rapidement que certaines sont crawlées par Seolyzer mais pas par Googlebot, il s’agit des pages inconnues.

A l’inverse, certaines sont crawlées par Googlebot mais pas par Seolyzer, ce sont les pages orphelines. Le but est bien évidemment que les deux cercles se superposent au maximum

Pour l’outil, une page inactive est une page qui n’a généré aucune visite SEO dans les 30 derniers jours. Je vous détaille cette notion juste un peu plus bas.

Si Googlebot arrive à voir des pages que votre crawler n’arrive pas à détecter, c’est souvent lié à un problème de pages orphelines. C’est également un élément que je vais vous expliquer juste un peu plus bas.

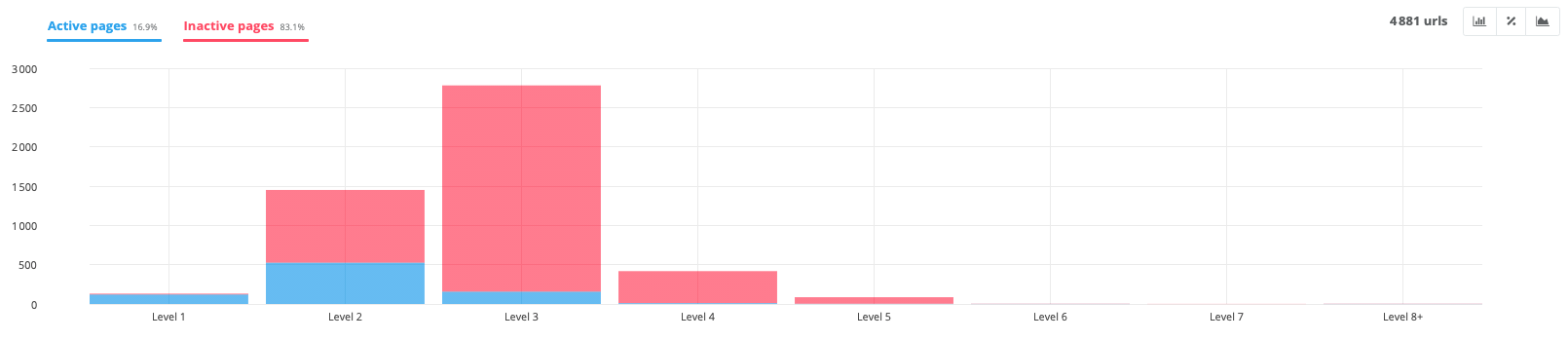

- Dashboard Graphiques n°2

Toujours dans le dashboard, le graphique à gauche propose une vision globale du pourcentage de pages actives et inactives sur le site.

En couplant les données, Seolyzer ressort que sur ce site, durant les 30 derniers jours 16,9% ont généré au moins une visite SEO, tandis que 83,1% n’ont généré aucun trafic.

En SEO, les pages inactives sont un véritable frein pour le site. Il y a donc fort à penser que ce site peut considérablement améliorer son référencement en les travaillant.

Le graphique de droite représente le pourcentage de pages qui sont maillées au sein de la structure du site (71,0%) et celles qui ne le sont pas (29%). C’est ce que l’on appelle les pages orphelines.

Là encore, c’est environ 30% des pages qui ne possèdent aucun lien interne et ne profitent pas du “jus SEO” interne. Il peut donc être très intéressant de rajouter des liens pour les ramener dans la structure.

- Active pages

Cet onglet donne le détail des différentes pages du site qui ont généré au moins une visite naturelle durant les 30 derniers jours.

- Inactive pages

Cet onglet donne le détail des différentes pages actives du site qui n’ont généré aucune visite SEO durant les 30 derniers jours.

Il faut, bien entendu, analyser chaque URL au cas par cas. En général, cette inactivité est liée à un manque de contenu ou encore à un niveau de profondeur trop élevé dans l’arborescence du site.

- Active vs Inactive

Ce graphique est plutôt intéressant puisqu’il met en corrélation les pages actives et inactives du site selon leur niveau de profondeur.

Comme la plupart des référenceurs le précise, le niveau de profondeur joue un rôle important dans son positionnement. Plus une page est profonde dans le site et moins elle a de puissance.

Cet exemple vient le confirmer !

Sur le graphique, on voit, très rapidement, que plus on descend dans l'arborescence du site (niveau 3 et 4) et plus le pourcentage de pages inactives augmente.

Il peut donc être intéressant de travailler la structure du site pour les rapprocher au maximum de l’accueil.

- Orphans

Les pages orphelines sont celles crawlées par le bot de Google mais qui ne ressortent pas lors de votre crawl. Ce sont souvent celles que Google connait mais qui ne font plus ou pas partie de votre arborescence.

Elles sont classifiées selon différentes catégories pour vous aider dans votre analyse :

L’onglet “Pages” contient celles qui répondent en 200 mais qui ne sont pas reliées à la structure de votre site.

Il est possible de retrouver le fichier robots.txt, le fichier sitemap, des URLs avec des paramètres (affiliation, utm, etc), etc.

Bien entendu, vous pouvez y découvrir des pages importantes pour votre business qui ne possèdent plus aucun lien interne depuis votre site. Ces cas de figure peuvent souvent apparaître à la suite d’une refonte de site ou de créations de landing page par exemple.

Pour ces pages, il est important de les intégrer à nouveau dans votre site pour leur redonner de la puissance.

L’onglet “Redirects” affiche les redirections suivies par Googlebot qui ne sont pas présentes dans la structure de votre site.

Par exemple, si vous avez changé l’URL d’une page et installé une redirection 301, le robot va continuer de visiter l’ancienne pendant quelques semaines. Celle-ci ne sera plus maillée dans votre site mais le moteur de recherche va continuer à la visiter.

L’onglet “Errors” représente celles en erreur 404, non présentes dans votre structure.

Par exemple, si une page de votre site qui n’existe plus possède des backlinks, elle sera visitée par Googlebot mais répondra en erreur. Il serait donc intéressant de la rediriger !

Enfin “Others”, liste les autres types d’URLs orphelines que le bot Google a rencontré. Par exemple, celles supprimées de votre site avec un code 410.

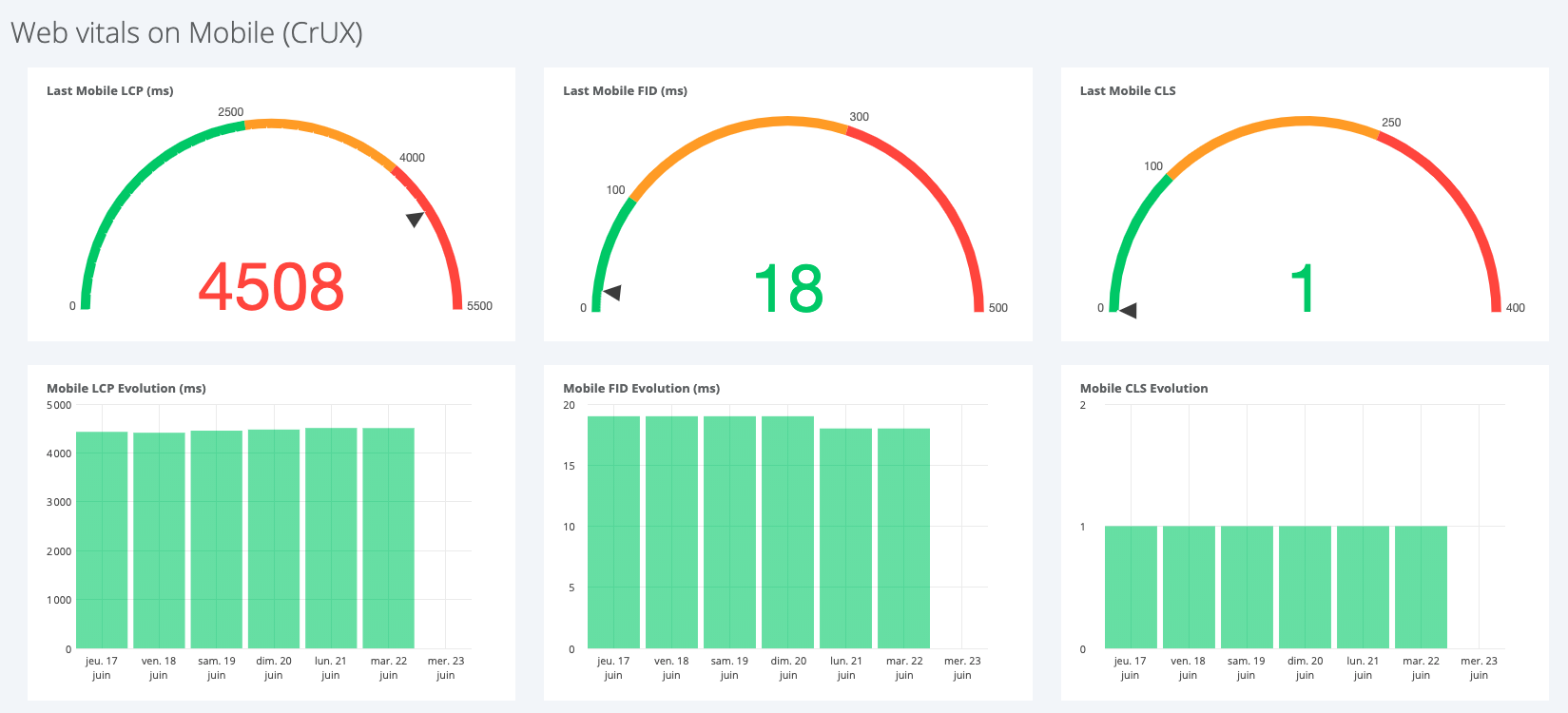

Core Web Vitals

Les Core Web Vitals sont représentés par 3 indicateurs (LCP, FID & CLS) qui s’ajoutent aux signaux de l’expérience utilisateur (mobile friendly, navigation sécurisée, HTTPs et interstitiels intrusifs). Ces données sont maintenant intégrées dans l’algorithme de classement de Google.

Dans l’onglet « Core Web Vitals », Seolyzer vous affiche un dashboard avec ces éléments, récupérés directement depuis la base de données CRUX.

Via les navigateurs Chrome, Chromium et Android, cette BDD récolte en continue les informations liées à l’expérience utilisateurs. Les informations sont très pertinentes puisqu’elles reflètent l’expérience réelle vécue par les internautes.

Je prévois de rédiger un article complet sur les Core Web Vitals, afin de vous expliquer plus en détails ces nouveaux indicateurs et à quoi ils correspondent dans votre site web.

Monitoring

La dernière section “Monitoring” de Seolyzer permet d’avoir un suivi de votre robots.txt, un des fichiers les plus sensibles en SEO.

Dès qu’une modification de ce fichier va être détectée, vous recevrez une alerte par email.

Si celui-ci est également non détecté et renvoie par exemple une erreur 500, le logiciel vous envoie également une alerte, et conserve l'historique de toutes les versions.

En conclusion, Seolyzer permet de travailler des données avancées tout en profitant d’une interface visuelle et accessible.

Avec ce guide, vous avez maintenant toutes les cartes en main pour l’utiliser efficacement et optimiser votre référencement naturel !

Profitez d'une promotion de 10% sur votre abonnement mensuel à l'outil avec le code "wizi" !

Testez WiziShop gratuitement pendant 7 jours

ACCOMPAGNEMENT PERSONNALISÉ 100% FRANÇAIS

✅ Aucune CB requise

✅ Accès à toutes les fonctionnalités

✅ Sans engagement